要旨

研究を加速できるAIは、わずか数年間で1世紀分の技術進歩をもたらす可能性があります。そのような期間中、新たな技術的または政治的発展により、重大かつ覆しにくい決断が次々と迫られることになるでしょう。私たちはこれらの発展を「大きな課題」と呼びます。

これらの課題には、新たな大量破壊兵器、AIを活用した独裁体制、宇宙資源の獲得競争、道徳的配慮に値するデジタル存在などが含まれます。同時に、生活の質や集団的意思決定を劇的に改善する機会も含まれます。

私たちは、これらの課題が常に将来のAIシステムに委任できるわけではないと主張し、今日私たちが見通しを意味のある形で改善するためにできることを提案します。したがって、AGI(汎用人工知能)への準備は、高度なAIシステムが整合性を持つことを確保するだけではありません:私たちは今、知能爆発がもたらす混乱を招く様々な発展に対して準備を進めるべきです。

1. はじめに

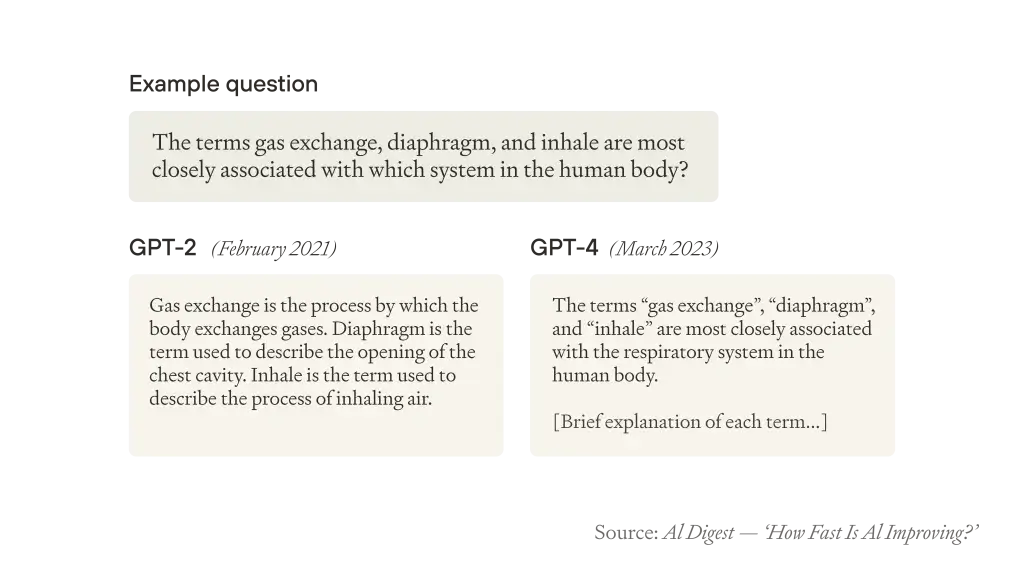

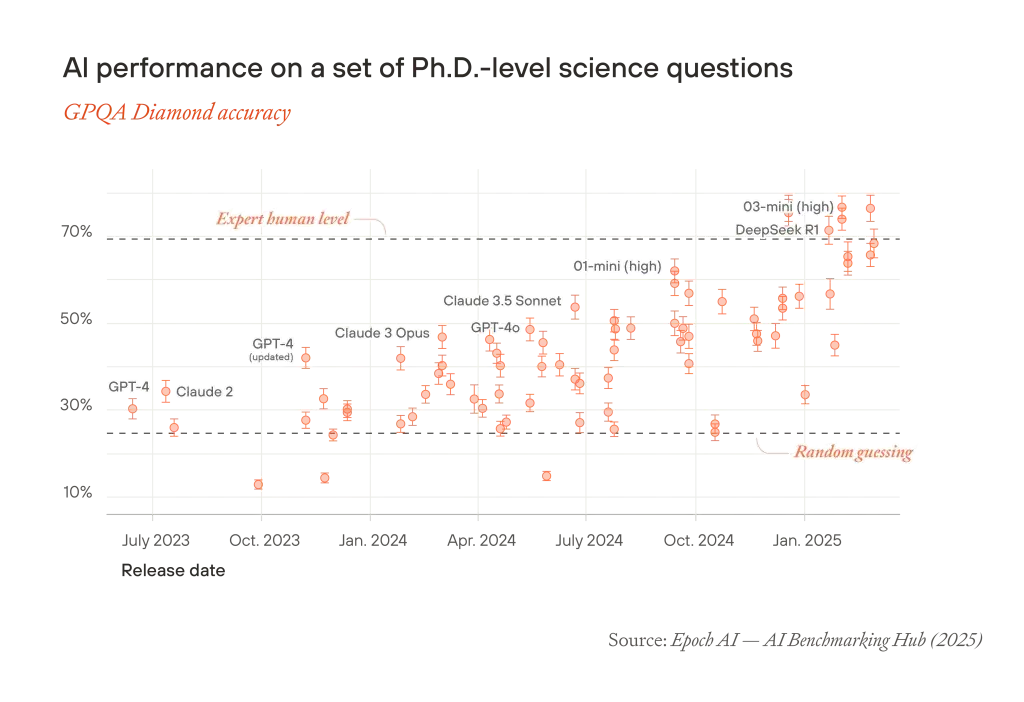

今後10年以内に人間よりもはるかに賢いAIが登場する可能性が真剣に考えられています。2019年の最高の言語モデルはほとんど一貫性がありませんでしたが、2023年初頭には流暢に質問に答え、生きている人間よりも幅広い一般知識を持つようになりました。2023年初頭の最高モデルは、推論を要する科学的質問ではランダムな推測よりわずかに良い程度でしたが、今日では博士レベルの専門家よりも高いスコアを出しています。

しかし、超知能AIを予想する人々の間では、結果は事実上「すべてか無か」であり、AI整合性(アライメント)という一つの課題に依存するという見方が一般的です。AIの整合性に失敗すれば人類は永久に力を失い、成功すれば他のすべての問題を解決するためにAIを使用できるというものです。

本論文はこの「すべてか無か」の見方に反論します。代わりに、AGI(汎用人工知能)への準備はより広範な機会と課題をカバーすべきだと主張します。

人間の研究労働に意味のある代替となるAIの開発は、おそらく非常に急速な技術開発を促進し、数十年分の科学的、技術的、知的発展を数年または数ヶ月に圧縮するでしょう。これはもちろん、過去の技術進歩が定期的に生活の質を向上させてきたように、生活の質を大幅に向上させる可能性をもたらします。健康寿命を劇的に延ばす医学的進歩、今日の億万長者が羨むようなライフスタイルを誰もが享受できる物質的豊かさ、前例のないレベルの調整、協力、有能なガバナンスのためのツールを意味する可能性があります。

しかし、それはまた、知能爆発の恩恵を享受するために解決する必要がある、途方もない範囲の課題ももたらすでしょう。そのような大きな課題が本論文の主な焦点です。広く議論されている課題の一つは、AIによる支配のリスクです:十分に高度なAIが人類と整合せず、人類を圧倒する可能性があるというものです。しかし、他にも多くの大きな課題があります:

- 超知能を制御する者による人間支配のリスク

- 生物兵器、ドローンの群れ、ナノテクノロジー、そして我々がまだ具体的に予想していない技術など、破壊的技術からの新たなリスク

- デジタル存在の権利や新たに価値のある宇宙外資源の配分など、重要な倫理的問題に関する規範、法律、制度の確立

- 社会の集合的認識論を歪めるのではなく、改善するAIの能力を活用する課題

これらのような大きな課題は、将来がどれだけうまくいくかを意味のある形で決定する可能性があります。それらは人類の進歩における岐路です。多くの場合、事前に準備しない限り、デフォルトでうまくいくとは期待できません。

知能爆発による変化の加速したペースのため、世界はこれらの課題に速やかに対処する必要があり、人間の制度が設計されているよりもはるかに短い時間スケールで対応しなければなりません。デフォルトでは、長期的な熟考や遅い試行錯誤の時間は単純にないでしょう。

整合した超知能はこれらの課題の一部を私たちのために解決できるかもしれません。しかし、すべてではありません。一部の課題は整合した超知能が登場する前に発生し、AGI後の権力共有の合意や、現在の遅い制度の改善など、一部の解決策は知能爆発が発生する前に取り組んだ場合にのみ実現可能です。

実際、今日これらの課題に備える方法があります。例えば:

- 極端で覆しにくい権力の集中を防ぐために、今から制度と政策を確立する。例えば、データセンターや半導体サプライチェーンの重要な構成要素が民主的な国々に分散され、最先端AIへのアクセスが国内外の多くの当事者に引き続き利用可能であることを確保する。

- 責任ある行動者を強化する:超知能の開発に最も影響力を持つ行動者(政治家やAI企業のCEOなど)が責任感があり、有能で、説明責任を負うようにする確率を高める。

- 集団的意思決定を改善するAIツールを構築する。認識論、取引、意思決定アドバイスにわたって、知能爆発が進行中の時点で広く使用されることを望むAIツールの構築、テスト、統合を開始できる。

- 超知能AIを下流の課題に適用する障害を取り除く。例えば、政府で高度なAIツールを使用することを不必要に困難にする官僚主義を解除する。

- デジタル存在の権利や宇宙外資源の財産権主張のための法的枠組みなど、新しい統治領域の制度設計に早期に着手する。

- 知能爆発とそれに続く各課題についての認識を高め、理解を深める。これにより、決定が必要な重要な瞬間に速やかに対応できるようになる。

次のセクションでは、知能爆発がどれほど劇的で破壊的なものになるかを示すために、歴史的な思考実験を提示します。その後のセクションでは:

- 人間の研究者に代わることができるAIが10年間で1世紀分の技術進歩を促進すると主張します(セクション3)

- その結果生じる広範な大きな課題の概要を示します(セクション4)

- これらの課題への準備がいつ後回しにできるか、できないかを議論します(セクション5)

- それらに備えるために今日できることをいくつか提示します(セクション6)

2. 10年で1世紀

- 圧縮された過去の1世紀

- 非対称的な加速

- 加速された10年間

- AI能力の進歩

- AIはどこまで改善し続けることができるか?

- 今後10年間のAI進歩の推定

- AI-人間の認知的同等性

- AIによる支配

- 高度に破壊的な技術

- 人間による支配

- 宇宙資源の配分

- デジタル存在の権利

- 集合的認識論

- 他の課題

- 機会

- 課題への対応

- 早期に生じる課題

- 早期に閉じる機会の窓

- 先例の設定

- 時間的遅れ

- 無知のベール

- 人々が超知能の支援をいつどのように使用するかの変化

- 超知能が私たちを助ける時期を早める

- 超知能の支援の性質を改善する

- 超知能の支援へのアクセスを持つ人を変える

- すべてをまとめる

- 意思決定の全般的な改善

- 特定の課題への対処

- デジタルマインドへの準備

- 宇宙ガバナンス

- 特定の専門知識

- 不確実性にもかかわらず準備する

- 不整合(misalignment)だけではない

- すべての問題を超知能(superintelligence)に先送りしない

- 適応する準備をする

- 8. 結論

- 免責事項

圧縮された過去の1世紀

1925年から2025年までの過去1世紀の間に見られた新しいアイデア、発見、技術を考えてみましょう:

科学的・概念的

物理学の進歩(量子論や現代宇宙論を含む)。DNAの構造解明とその後のゲノミクスと生物学の進歩。計算理論とコンピュータサイエンス、ゲーデルの不完全性定理、暗号学、最適化と線形計画法、新しい統計手法。ゲーム理論、マクロ経済学とエコノメトリクス、政治学、実験心理学、予測など、当時は初期段階だった社会科学における大きな進歩。環境劣化についての理解の大幅な向上。

技術・工学

アサルトライフル、ジェット機、レーダーとステルス技術、衛星偵察、生物・化学兵器、無人ドローン、原子爆弾。ペニシリン、経口避妊薬、DNA指紋鑑定、合理的薬剤設計、遺伝子工学。トランジスタラジオ、デジタルコンピュータ、携帯電話、インターネット、ソーシャルメディア、GPS、ディープラーニング。フラッキング、沖合掘削、国家電力網、原子力発電、太陽光発電。合成肥料、高収量作物品種、トラクターやコンバインによる機械化、遺伝子組み換え作物。

政治・哲学

世俗的・普遍的人権の採用、第二波・第三波フェミニズム、脱植民地化、動物の権利、環境主義。ファシズム、国家共産主義(毛沢東主義やレーニン主義など)、新自由主義、国際関係における「現実主義」の広がり。政治的・社会的正義の新理論、規範倫理学の新理論、政策評価のための費用対効果アプローチ、人口倫理学。論理実証主義、日常言語哲学、実存主義、批判理論、(ポスト)構造主義、(ポスト)モダニズムなど。

ここで、これらすべての発展が1925年以降の10年間に圧縮されたと想像してみてください。

太平洋横断の初の無着陸飛行は1925年後半に行われるでしょう。月面への最初の足跡は4年も経たない1929年半ばに続くでしょう。核分裂の発見(1926年半ば)と原子爆弾の最初のテスト(1927年初め)の間はわずか200日ほどで、コンピュータチップ上のトランジスタ数は4年間で100万倍に増えるでしょう。

これらの発見、アイデア、技術は大きな社会変化をもたらしました。これらの変化も10倍に加速したと想像してみてください。第二次世界大戦は産業超大国間で勃発し、原子爆弾で終結するまでがわずか7ヶ月ほどの期間です。ヨーロッパの植民地帝国の解体後、30の新しい独立国家と成文憲法が1年以内に形成されるでしょう。国際連合、IMFと世界銀行、NATO、そして後にヨーロッパ連合となるグループは、8ヶ月もかからずに形成されるでしょう。

あるいは、核兵器に関する決定だけを考えてみましょう。10倍の加速では、マンハッタン計画は1926年10月に開始され、最初の爆弾は3ヶ月後に広島上空に投下されます。平均して、核の危機は年に1回以上発生します。1928年後半に始まるキューバ危機はわずか31時間続きます。JFKはフルシチョフの最後通告にどう対応するかを20分で決断します。アルヒポフは、戦争が勃発したと誤って確信した艦長を説得して核魚雷の発射を阻止するのに1時間もありません。等々。

このような急速なペースは、どのような決定が下されたかを変えていたでしょう。キューバ危機を振り返り、交渉に役割を果たしたロバート・F・ケネディ・シニアは次のように書いています:「もし24時間以内に決断を下さなければならなかったとしたら、私たちが最終的に取ったであろう道筋はかなり異なり、はるかに多くのリスクを伴っていただろう」

非対称的な加速

もし文字通りすべての歴史的プロセスが均一に加速したとしたら、同じ出来事がただ速く起こるだけで、歴史の軌跡は変わらないでしょう。しかし、技術変化はすべてを均等に加速させるわけではありません:技術進歩の加速は、それに伴って加速しないプロセスを遅くするようなものです。特に、人間自身、そして彼らの相互作用、思考、学習を加速させることは難しいです。同様に、多くの社会的・政治的制度は硬直したスケジュールを持っており、周囲の世界が加速するにつれて遅れをとる可能性があります。

したがって、別の思考実験として、1925年から2025年の期間に同じ規模の技術変化があったが、すべての人間が1日にわずか1時間40分だけ起きていたとしたらどうでしょうか。意思決定は明らかに損なわれるでしょう:新しい発展とその意味を理解する時間が少なくなり、迅速に行動するプレッシャーが高まれば、大きな失敗の可能性は高まるでしょう。

加速された10年間

ここで、技術進歩が過去1世紀とほぼ同じペースで次の1世紀にわたって続いた場合、2125年までに見られるであろうすべての科学的、知的、技術的発展を想像してみてください。そして、それらすべての発展がわずか10年間で起こると想像してみてください。

歴史的思考実験のように、この加速がもたらす課題は膨大なものでしょう。しかし、次のセクションでは、これは単なる思考実験ではないと主張します:実際、高度なAIが10年未満で1世紀分の技術開発を推進する可能性が高いのです。

技術開発の加速は均一ではないでしょう。なぜなら、AIからの豊富な認知労働は、研究のある分野を他の分野よりも加速させるからです。数学、コンピュータサイエンス、計算生物学のような先験的推論やシミュレーションによって進歩できる領域では進歩が加速し、高エネルギー粒子物理学や薬剤開発のような高価または遅い実験が必要な領域では進歩はそれほど爆発的ではないでしょう。

歴史的思考実験と同様に、重要な意思決定の質とスピードは常に変化のペースに追いつくわけではないでしょう。超知能AIアドバイザーは大いに役立つかもしれませんが(セクション5で議論する方法で)、良い意思決定は依然として人間の脳のスピードと制度的スケジュールのペースによってボトルネックとなり、人間の寿命のタイムスケールでの試行錯誤による通常の制度的学習方法は遅すぎるでしょう。

私たちは、この加速した技術進歩のペースが通常のビジネスのペースよりも悪いと主張しているわけではありません。しかし、このような急速な進歩は、主に人間の意思決定が追いつくのに苦労するため、独特の課題をもたらすと主張しています。そしてそれは、今から準備すべきであることを示唆しています。

3. 知能爆発とその先

ここでは、AIの進歩がはるかに速い技術開発のペースを促進するという議論に目を向けます。

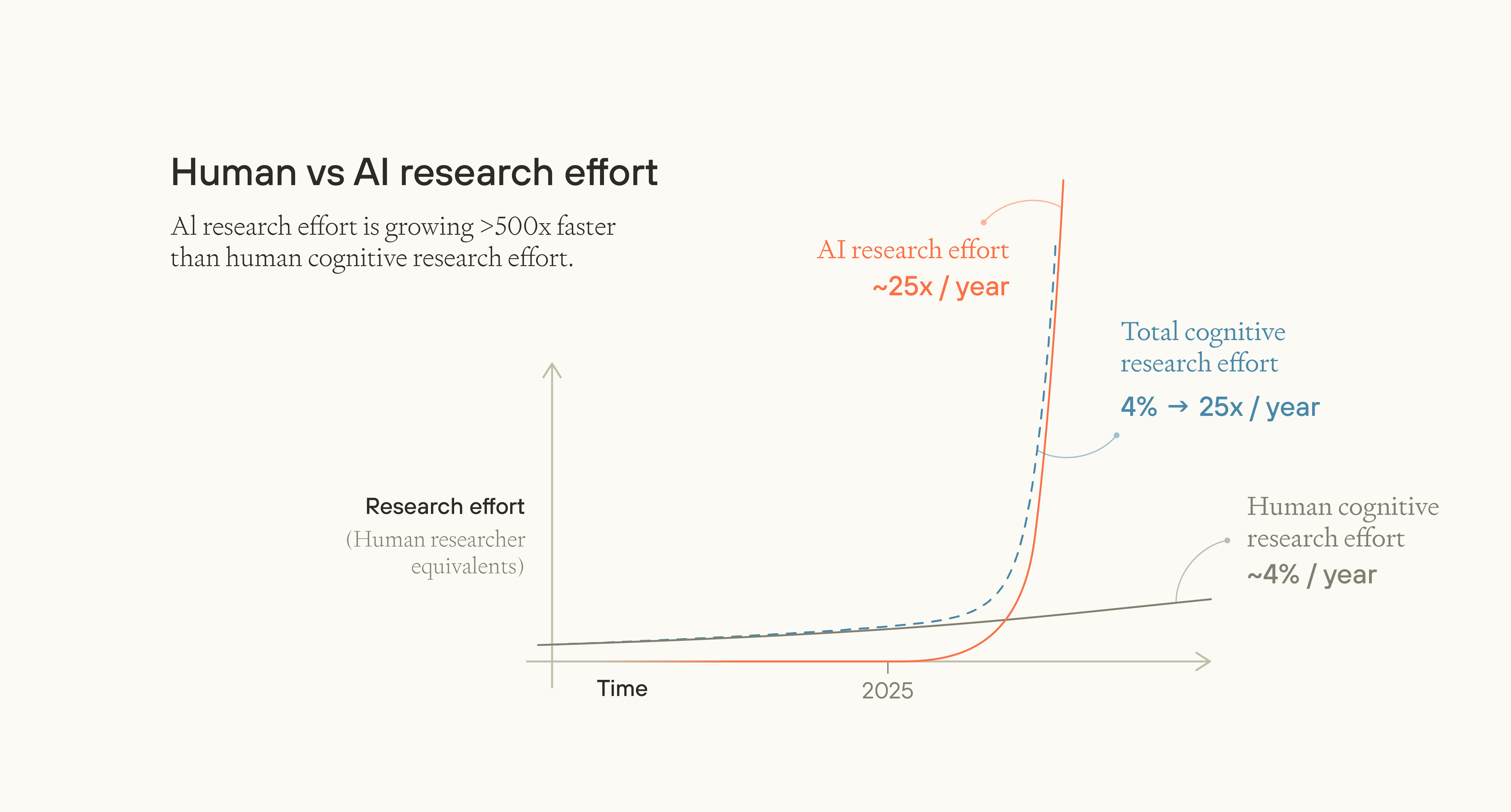

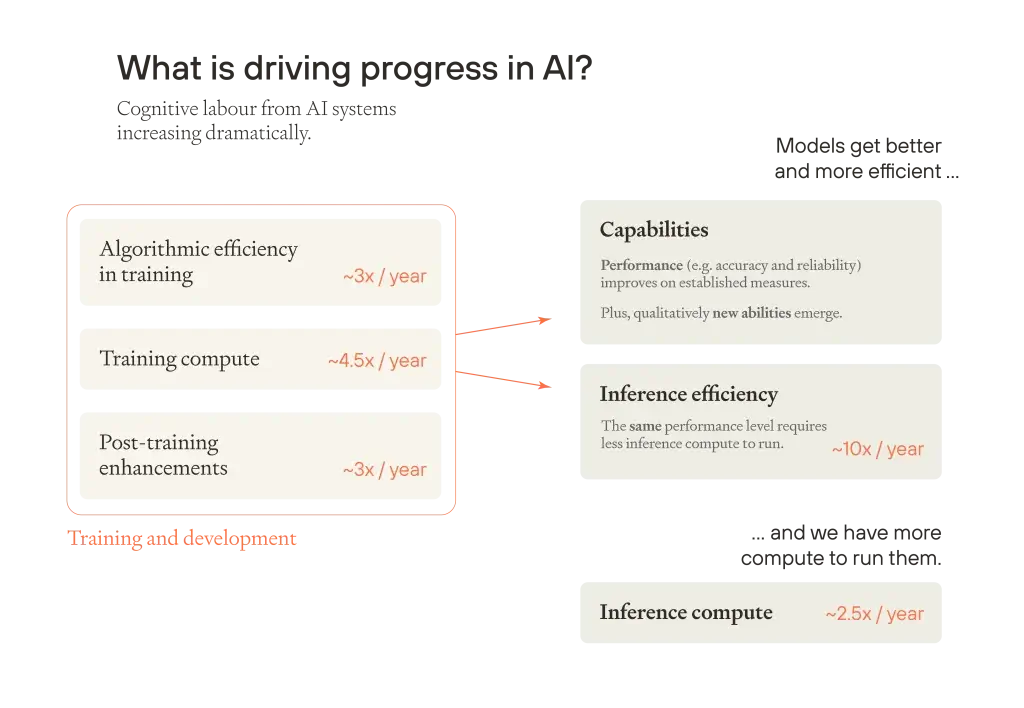

この議論を簡潔に述べると次のようになります。現在、世界全体の研究努力は緩やかに成長しており、年間5%未満の増加率です。しかし、AI全体の認知労働(cognitive labour)は人間全体の認知労働よりも500倍以上速く成長しており、AIの認知能力が全人類を超えるポイントまでこの傾向が続く可能性があります。したがって、AI全体の認知労働が人間全体の認知労働に匹敵し始めると、全体的な認知労働の成長率は大幅に増加します。それがより速い技術進歩を促進することになります。

このセクションでは、この議論をより詳細に説明します。現在および予想されるAI進歩の速度を検討し、AIが10年以内に研究を意味のある形で加速させると予想する理由と、AIが人間と同等レベルに達する時点が間もなく来るかもしれないと考える理由について議論します。この時点で、AIからの研究努力の持続的な成長率は、人間の研究の成長率よりもはるかに高くなる可能性が高く、10年未満で1世紀分の技術進歩を推進するのに十分であると主張します。最後に、これがなぜ産業拡大も爆発的に促進する可能性が高いかについて議論します。

AI能力の進歩

現在のトレンド

最高のAIモデルはより賢くなり、特定のパフォーマンスレベルのモデルはより効率的になり、それらを実行するためのコンピューティングパワーもより多く蓄積しています。その結果、AIシステムの総認知労働は毎年劇的に増加しています。

AIの進歩の主要な推進要因

AIの進歩の主要な推進要因を順に見ていきましょう。

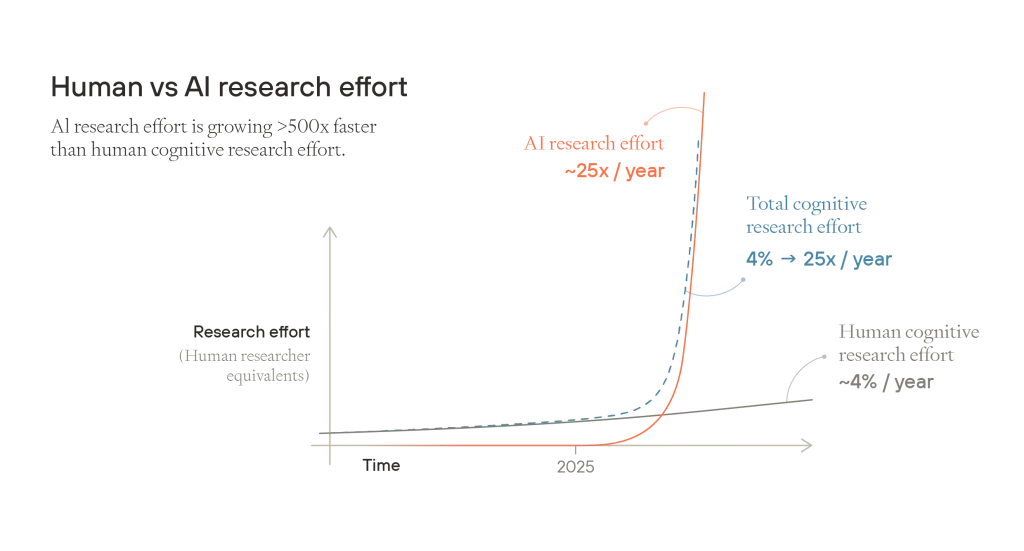

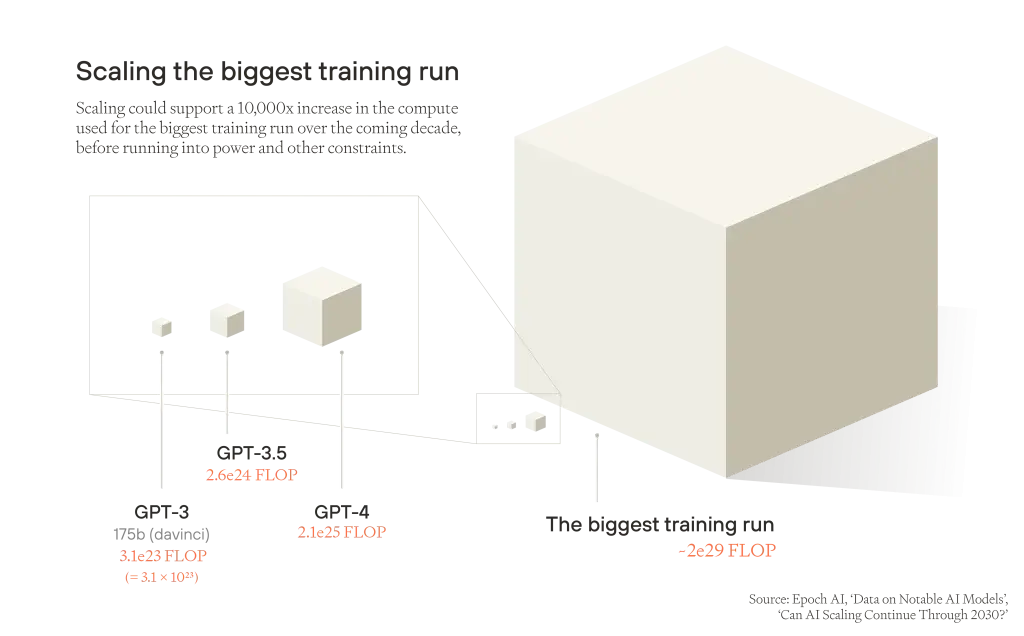

トレーニングコンピュート(Training compute): 注目すべきフロンティアトレーニング実行に使用される計算量の推定値は、2010年以来年間約4.5倍のペースで拡大しています。より大規模なトレーニング実行により、より優れたモデルが生まれます。

トレーニングにおけるアルゴリズム効率: 新しく改良されたアルゴリズムによりトレーニングの効果が向上し、同じ量のトレーニングコンピュートがより効率的になります。現在のトレンドでは、同じレベルのパフォーマンスでモデルをトレーニングするために必要な物理的計算量は年間約3倍のペースで減少しています。

これら2つの要因が組み合わさって「効果的トレーニングコンピュート(effective training compute)」の指標となります-アルゴリズムの革新なしに同じモデルパフォーマンスに到達するために必要な生の計算量の等価増加です。事前トレーニング(pretraining)からの効果的トレーニングコンピュートは年間10倍以上のペースで増加しています。

トレーニング後の強化(Post-training enhancements): これに加えて、AI開発者はベース(事前トレーニング済み)モデルから新しい能力を引き出す方法を見つけています。彼らは「トレーニング後の強化」をツール使用、より良いプロンプト方法、合成データ、回答を生成・選択する創造的な方法、様々な「足場(scaffolding)」などの分野で構築しています。これらの進歩の多くは、より多くの推論コンピュート(inference compute)をより効果的に活用し、本質的にトレーニング済みのベースモデルにより効果的に推論するよう教えています。Anthropicは非公式に、トレーニング後の強化が現在、年間さらに3倍の効率向上をもたらしていると推定しています。したがって、最高モデルの能力に関しては、物理的トレーニングコンピュートが年間30倍以上のペースで拡大しているかのようです。

これらのトレンドは、確立された指標とベンチマークを持つ馴染みのあるAI能力のパフォーマンスを、しばしば予測可能な方法で向上させます。しかし、より大きく優れたトレーニング実行からは、質的に新しい能力も生まれ、しばしば微妙で驚くべき方法で現れます。したがって、GPT-2とGPT-4の間の実世界の違いと、それが私たちのトレンドにどのように対応するかを考えることが有用かもしれません。GPT-4は、約4年前にリリースされたGPT-2の10^5(10万)から10^6(100万)倍の効果的トレーニングコンピュートを使用してトレーニングされました。トレーニング後の強化も考慮すると、効果的コンピュートはおそらく1000万倍近く成長しました。これにより質的に新しい能力が生まれました:GPT-2は文法的には正しいが本質的に意味のないテキスト補完を生成していましたが、GPT-4は科学、法律、歴史、コーディングに関する高度な質問に答えることができるようになりました。

私たちはより効率的なモデルのおかげと、AI企業が推論(inference)用のコンピューティングハードウェアをより多く蓄積しているため、同じパフォーマンスレベルでより多くのモデルインスタンスを実行することもできます。順に見ていきましょう:

推論効率(Inference efficiency): GPT-3.5は2022年後半に100万トークンあたり20ドルの初期コストでリリースされました。今日では、MMULUスコア(LLMパフォーマンスを評価するための幅広いベンチマーク)がより高い、より高速で優れたモデルを100万トークンあたり約0.04ドルで実行することが可能です。これは3年未満で500倍のコスト削減、つまり年間約10倍のコスト低下率です。この数字にはいくつかの理論的裏付けがあります:効果的トレーニングコンピュートを2倍にすることは、確立された能力レベルの推論コストをおおよそ半分にすることに相当し、効果的トレーニングコンピュートは年間約10倍のペースで増加していることがわかりました。

推論コンピュートのスケーリング(Inference compute scaling): コンピューティングハードウェアの増加はこれらの効率向上を乗算します:推論に利用可能な物理的コンピュートの量は年間約2.5倍のペースで増加しています。

これら2つのトレンド-実行時効率の向上と利用可能な推論コンピュートの増加-は、「AI人口(AI population)」を年間約25倍のペースで成長させることをサポートできる可能性があります。

すべてのことが、最高のAIモデルの最も印象的な能力だけでなく、世界中で稼働しているすべてのAIシステムの集合的能力における急速な進歩につながっています。私たちは「AI研究努力(AI research effort)」という言葉を使って、ある時点でのすべてのアクティブなAIシステムによって貢献される研究関連の認知的努力の量について話します。非公式には、AIの研究努力を、同等の貢献をするために必要となる遠隔人間研究者の数という観点から測定することができます。

人間の認知的研究努力の総量は、研究者の純粋な数と、各研究者の平均生産性の関数です。同様に、AIの研究努力を各モデルの能力と「AIリサーチャー」の量の関数として考えることができます。

現在のトレンドがAIの研究努力が人間の研究労働とほぼ同等になるポイントまで続くと仮定しましょう(以下では、これが起こりそうかどうかについて議論します)。議論のために、実際の人間の研究者と同じ効果的な数の人間レベルの「AIリサーチャー」を想像するかもしれません。これは技術進歩に向かう全体的な認知労働の成長率にどれほど根本的に影響するでしょうか?

トレーニングの進歩がすべて推論効率の向上に変換され、より多くの推論コンピュートがすべてより多くのAIを実行するために使用されると仮定することで、ベースラインを推定することができます。推論効率は効果的トレーニングコンピュートとほぼ一致して年間約10倍のペースで向上し、推論コンピュートは年間2.5倍以上のペースで増加していることがわかりました。したがって、現在のトレンドが研究努力の点で人間とAIの同等性のポイントまで続くならば、AIの研究努力は少なくとも年間25倍のペースで成長し続けると結論づけることができます。

しかし、これはAI研究努力の成長率を過小評価している可能性があります。上記では、AI駆動の研究に利用可能な効果的トレーニングコンピュートを2倍にすることが、AIリサーチャーの人口を増やすためだけに排他的に使用されると仮定しましたが、代わりにより少ないがよりスマートなモデルを実行することを可能にする可能性があります。より効果的なトレーニングコンピュートが前世代と同じ能力レベルで2倍効率的なモデルをもたらし、同じ推論コンピュートを使用する新しい能力を持つモデルをもたらす場合、同じ数のよりスマートなAIは、同じくらいスマートなAIの2倍の数よりもはるかに集合的に能力が高くなることが多いでしょう。同様に、推論コンピュートを2倍にすることで、単に多くの研究者を実行するのではなく、AIリサーチャーごとの連続的推論時間を2倍にすることができます。そしてもちろん、両方の要因の任意の組み合わせが可能です。トレーニングと推論からの利益は、最も生産的な場所に適用されることを期待すべきであり、AIの実用的なアプリケーションは実際に能力の公共フロンティアに近いモデルを使用する傾向があることも観察できます。

人間レベルを超える能力向上を考慮した場合、AI研究努力がどれほど速く成長するかについての推定はしていませんが、それははるかに速い可能性があります。これを理解するために、人間の研究者は脳のサイズや教育年数においてわずかな違いしかありませんが、一部の分野では例外的な研究者は同僚よりも何百倍も生産的である可能性があることを考慮してください。

また、トレーニング後の強化からの効果的トレーニングコンピュートの年間3倍の増加とされるものをまだ考慮していません。これにより成長率は年間25倍から75倍に増加するでしょう。AIリサーチャーをより効率的にするだけでなく、よりスマートにするオプションを考慮した場合の追加の利益と組み合わせると、AI研究努力の総成長率はその数字をはるかに上回る可能性があります。

AIはどこまで改善し続けることができるか?

これらのスケーリングと効率性のトレンドはどれくらいの期間続くことができるでしょうか?

トレーニングコンピュート: 最大のトレーニング実行は、電力やその他の制限に直面する前に、さらに約10,000倍の増加まで継続してスケールアップすることができます(おそらく今から10年以内に)。その障壁が解決されたとしても、トレーニング実行はチップ生産、データの希少性、ハードウェアのレイテンシーからの制限に直面する可能性があります。

トレーニングにおけるアルゴリズム効率: コンピュートのスケールアップと効率向上の同じ比率を仮定すると、トレーニングにおけるアルゴリズム効率がさらに1,000倍向上し、今日の位置と比較して10年間でさらに1,000万倍の効果的トレーニングコンピュートの増加をもたらすでしょう – または10年間で効果的コンピュートの年間約5倍の増加 – これまでの年間10倍以上の進歩率よりも遅いペースです。

推論コンピュート: 推論コンピュートもこの期間に10,000倍のスケールアップし、年間2.5倍の継続的な増加を合理的に仮定することができます。

したがって、AIの進歩がスケーリングが可能な限り続き、それ以上は進まないと保守的に仮定すると、スケーリングの限界を使用して、集合的なAI研究努力が今後10年間でどれだけ成長する可能性があるかを推定することができます。AI研究努力を生み出すために組み合わさるトレーニングコンピュート、アルゴリズム効率、推論コンピュートの積は、1,000億倍(10^11)増加し、年間平均10倍強のペースになります。

AIの進化と自己強化サイクル

しかし、物理的なスケールアップは10年以内に限界に達する可能性がある一方で、アルゴリズムの進歩は劇的に加速する可能性があります。これは、AIモデル自体がAIアルゴリズム、データ、トレーニング後の強化、その他のソフトウェア技術の改善を意味のある形で加速し始める可能性があるためです。その結果、より優れたAIが生まれ、それがさらにアルゴリズムの改善を促進し、以下同様に続きます:これはソフトウェアフィードバックループ(software feedback loop)であり、物理的な入力をスケールアップする必要なく、AI能力が継続的に向上していきます。

自己持続的なソフトウェアフィードバックループは保証されているわけではありません。ほとんどの新技術は(良くても)研究者の生産性に対する一回限りの乗数効果にすぎないため、自己持続的な進歩を引き起こすことはできません。原則として、AIでも同様のことが起こり得ます。「デジタルMLリサーチャー」が典型的な人間のAI研究者に代わることができたとしても、進歩は頭打ちになる可能性があります:最初の世代のデジタルMLリサーチャーは次世代のAI研究者のパフォーマンスを2倍にする方法を見つけるかもしれませんが、第2世代のデジタルMLリサーチャーはパフォーマンスを1.5倍に向上させる方法しか見つけられないかもしれず、以下同様に続きます:その結果、始まるとすぐに減速する一時的な改善が起こります。進歩が急速かつ持続的であるためには、入力の倍増が少なくとも出力の倍増をもたらす必要があり、それが多くの倍増にわたって続く必要があります。

しかし、様々なソフトウェア領域における効率向上の実証的推定によれば、認知的入力(研究努力)を倍増させると、一般的にソフトウェアのパフォーマンスや効率が倍以上に向上することが示唆されています。これに基づくと、AI駆動のソフトウェアフィードバックループがAIのパフォーマンスと効率における加速的な進歩を促進する可能性は約50%と合理的に推定されます。

フィードバックループは永遠に加速し続けることはできないため、最終的にはソフトウェアフィードバックループは平坦化する必要があります。しかし、アルゴリズム効率の上限は現在のレベルからはるかに離れているようです。LLMは、私たちの脳が成人期までに使用する計算量の観点から見ると、人間よりも非常におおよそ10万倍効率が悪いようです。そして上限は人間の脳の効率をはるかに超えている可能性が高いです。

したがって、ソフトウェアフィードバックループが実現すれば、AI能力は同じ10年間で効果的トレーニングコンピュートにおいてさらに100万倍の要因をカバーする可能性があり、効果的トレーニングコンピュートの約1兆倍(10^12)の増加、または推論コンピュートと効果的トレーニングコンピュートの積の10京倍(10^16)の増加(年間約40倍)をもたらします。

いずれにせよ、推論コンピュートと効果的トレーニングコンピュートの積は、技術進歩に向けられたすべての人間の認知労働よりも少なくとも600倍速く成長しており、継続的な改善のための膨大な余地があります。

今後10年間のAI進歩の推定

以下の表では、今後10年間にわたって平均的にAI研究努力の構成要素がどれくらい速く成長し続けるかについての私たちの推測をまとめています。なお、与えられた成長率は平均値であり、特定の要因における成長のほとんどは非常に短い期間に集中する可能性があります。

| 現在の率 | 中程度のシナリオ(フィードバックループなし) | 急速なシナリオ(ソフトウェアフィードバックループあり) | |

|---|---|---|---|

| トレーニングコンピュート | 4.5倍/年 | 2.5倍(合計10,000倍) | 2.5倍 |

| アルゴリズム効率 | 3倍/年 | 2倍(合計1,000倍) | 8倍(合計10^9倍) |

| 推論コンピュートのスケールアップ | 2.5倍/年 | 2.5倍(合計10,000倍) | 2.5倍(合計10,000倍) |

| AI研究努力 | ≥25倍/年 | ≥12倍(合計≥10^11倍) | ≥50倍(合計≥10^17倍) |

| 人間研究者 | 4% | 4% | 4% |

| AI対人間研究努力 | ≥600倍速い | ≥300倍速い | ≥1000倍速い |

これらすべてをまとめると、現在のAI進歩の速度が現在のトレンドと比較して100倍遅くなったとしても、認知的研究労働の総量(人間とAIからの合同努力)は依然として以前よりもはるかに急速に成長するだろうと結論づけることができます。集合的AI能力が人間のそれと一致すると、この成長は全人類の集合的思考力をはるかに超えてAI能力を向上させ続けるでしょう。

次に、集合的AI能力が人間の研究努力と同等になるかどうか、そしていつになるかという問題に目を向けます。

AI-人間の認知的同等性

私たちには、AI研究努力が今後20年以内に人間の研究労働と同等になる可能性が高いと思われます。これは、AIシステムが集合的に人間ができるほぼすべての研究関連の認知作業を実行できることを意味します。スケーリングがそのような大きな利益を促進しているため、AIはスケーリングが電力やその他の実用的な制約に直面し始める前に、今後10年以内に人間との同等性に近づく可能性さえあります。そしてスケーリングが大幅に減速した後でも、アルゴリズムの進歩は進歩を前進させ続ける可能性があります。いずれにせよ、AI-人間の同等性は数年のうちに到来する可能性があります。

これを理解するには、AI能力がどのように向上しているかを直接見るべきです。博士レベルの科学的質問のベンチマークであるGPQAでは、GPT-4はランダムな推測よりわずかに良いパフォーマンスを示しました。18ヶ月後、最高の推論モデルは博士レベルの専門家を上回るパフォーマンスを示しています。

スキルに関しては、ML研究の自動化により関連性が高いものとして:最高のAIシステムはすでに競争的なコーディング問題において、最も優れたプログラマーを除くすべてのプログラマーを確実に上回り、オープンソースリポジトリの実世界のソフトウェアエンジニアリング問題の70%以上を解決し、時間制限付きの機械学習最適化問題において約4時間の時間制限まで(RE-Benchベンチマークにおいて)ドメイン専門家のスコアに匹敵します。今日の最高のシステムは、創造性、試行錯誤、自律性の組み合わせを必要とする、より長い時間軸にわたる複雑な問題を解決することにおいては不足しています。しかし、急速な改善の兆候があります:フロンティアモデルが一般的に完了できるML関連タスクの最大期間は、約7ヶ月ごとに倍増しています。このトレンドを素朴に外挿すると、3〜6年以内に、AIモデルは人間の専門家が最大1ヶ月かかる多くの認知タスクを自動化する能力を持つようになることが示唆されます。…したがって、少なくとも短い科学やコーディングタスクのパフォーマンスをテストするいくつかのベンチマークでは、AIシステムは関連する専門知識を持つ人間に追いついています。

もちろん、ベンチマークは実世界ではありません。ML研究を例にとると:RE-Benchのような厳しいベンチマークでさえ、自己完結型で明確に定義されたタスクを素早いフィードバックループで提示します。一方、実世界では、MLリサーチャーは研究の方向性を明確にして選択し、他のチームと調整する必要があり、実験の結果を数日待つことがよくあります。実際の研究とエンジニアリングを自律的に推進できるAIシステムを構築し統合するには、さらに多くの作業が必要ですが、専門家レベルのベンチマークパフォーマンスと実世界での専門家レベルの有用性の間のギャップを埋めるための大きなインセンティブがあります。…GPT-2(基本的な質問に対してほとんど一貫性のない回答を提供する)とGPT-4(生きている人よりも多くの一般知識を持つ有用なアシスタント)の間には、効果的トレーニングコンピュートの約100万倍の差があります。18ヶ月で、モデルは特定の推論とプログラミングタスクにおいて博士レベルの専門家に匹敵するまで十分に改善されました。スケーリングのボトルネックに直面する前に、GPT-2とGPT-4を分けたアルゴリズムの進歩とトレーニングコンピュートの少なくとも同じ飛躍を期待すべきです。ソフトウェアフィードバックループが実現すれば、再び同じような飛躍を得て、「GPT-8」相当以上に到達する可能性があります。…このような激しい進歩は、基本的にすべての重要な認知領域において、最も賢い人間の研究者の研究能力を超えるモデルを生み出すのに十分である可能性が高いと思われます。しかし、今後5年間のトレーニングコンピュートの予想されるスケールアップがそこに到達しなくても、事前トレーニングのアルゴリズム効率、トレーニング後の強化、推論効率、推論コンピュートのスケールアップは、物理的なスケーリングが減速したり、トレーニングデータが枯渇したりするポイントを超えてAI研究努力を増加させ続けるでしょう。

したがって、それがいつ起こるかを確実に知ることはできませんが、今後数年以内に研究における最高の人間のパフォーマンスとAIの同等性は、私たちにとって単なる生きた可能性以上のものに思えます-それはかなり可能性が高いと思われます。そしてそれが起こると、集合的なAI研究能力は多くの桁にわたって増加し続けるでしょう。…したがって、私たちは例えば、10万人の人間の専門家レベルのAI研究者の効果的な人口から始めるかもしれません。おそらくその大部分は次世代のAIの改善や、科学技術の他の分野-リターンが最も高い場所-で働くでしょう。その後、効果的なコンピュートの進歩と推論コンピュートの増加により、認知的努力の量が少なくとも2倍になり、再び2倍になり、急速に約1,000万人の働く人間の研究者全員を、そして80億人の生きている人間全員を知的に上回り、その後集合的能力を何度も2倍にしていくでしょう。…もちろん、専門化されたAIアプリケーションはすでに、追加の人間の研究者を加えるよりもはるかに効果的に特定の領域での進歩を推進しています-例えば、Google DeepMindのAlphaFoldは2億以上の新しいタンパク質構造を予測するために使用されており、ある意味では実験的方法では数百万の研究者年がかかったであろうことを達成しています。私たちは人間の研究者と同じスキルプロファイルを持つ汎用AIリサーチャーの使用だけに限定されることはありません。

AI-人間の同等性後のAI研究努力はどれくらい増加するか?

では、AIが人間の認知的研究努力と同等になった後の10年間で、AI研究努力がどれくらい成長するかを問うことができます。これは2つの推測に依存します:AIの能力がすでに人間との同等性にどれだけ近いか、そして全体的なAI能力の持続的かつ急速な改善にどれだけの余地があると考えるかです。…私たちの保守的なシナリオでは、AIの能力が電力制約のためにトレーニング実行のさらなるスケールアップがもはや不可能な時点で人間と同等になると想像し、ソフトウェアフィードバックループがないと仮定します。さらに、推論コンピュートの成長と効率の進歩が現在の速度から約30%減速すると仮定します。このシナリオでは、AI研究努力は人間との同等性に達した後の10年間、平均して年間5倍のペースで拡大し続けるでしょう。

私たちの積極的なシナリオでは、集合的なAI能力がすぐに人間と同等になり、トレーニング実行と推論コンピュートのスケールアップにまだ十分な余地があり、AI R&Dを自動化するAIがソフトウェアフィードバックループをもたらすと想像します。

| 保守的 | 積極的 | |

|---|---|---|

| トレーニングコンピュート | 成長なし | 2倍(合計1,000倍) |

| アルゴリズム効率 | 2.5倍(合計10,000倍) | 5倍(合計10^7倍) |

| 推論コンピュートのスケールアップ | 1,000倍(2倍/年) | 2.5倍(合計10,000倍) |

| AI研究努力 | ~10^7倍(5倍/年) | 25倍(~10^14倍以上の合計) |

| 人間研究者 | 1.04倍/年 | 1.04倍/年 |

| AI対人間研究努力 | 100倍速い | 600倍速い |

技術爆発

次の疑問は、技術進歩に何が起こるかです。技術進歩の速度は歴史的に熟練した人間の研究者の供給によって駆動され、制限されてきました。制度的および文化的要因も重要ですが、(他のすべてが等しければ)より多くの研究者がより多くの研究を生み出すことを否定する人はほとんどいないでしょう。全体的な認知的研究努力の量を増やすことで、AI研究努力は効果的に熟練した人間の研究者の供給を増やすことができます。効果が十分に大きければ、結果として技術爆発が起こる可能性があります:社会の技術進歩率の大きく持続的な増加、おそらく10年間で1世紀分の技術進歩に十分なほどの増加です。…総研究努力の増加の効果のモデル化では、2種類の収穫逓減を考慮する必要があります。第一に、「釣り尽くし」効果:研究されたほぼすべての分野において、累積的な技術進歩が多くなるほど、同じ進歩率を維持するためにより多くの研究努力が必要になります。第二に、「足を踏む」効果:並行してより多くの研究努力を加えることには、しばしば収穫逓減があります。

私たちはこれを半内生的成長モデルからの単純なアイデア生産関数を通じてモデル化し、2種類の収穫逓減を組み込みます。10年間で1世紀分の進歩を推進するためには、その10年間で総研究努力が600倍以上増加する必要があります。つまり、年間約100%(1倍増)の成長率が必要です。

人間との同等性後の10年間におけるAI進歩の保守的なシナリオでは、総研究努力は10^7倍、つまり年間約5倍増加するでしょう。これは現在の進歩率で300年以上分の技術開発を推進するのに十分でしょう。集合的なAI能力の10年ごとの成長が私たちの保守的な推定が示唆するよりも半分以上遅くても、10年間で1世紀分の技術進歩を得ることになるでしょう。…ここまで、AIリサーチャーからの認知的努力が人間の研究努力を単純に代替でき、技術進歩のペースは単に認知的努力-先験的で非身体的な思考-の関数であると仮定しています。しかし、研究には物理的な実験や試行錯誤も含まれます。したがって、研究に利用可能な物理的労働が認知的労働と一致して成長しない限り、それは技術進歩をますます妨げるでしょう。同様に、技術進歩はしばしば、人間の薬物試験のように連続して実行する必要があるか、簡単に速度を上げることができない実験を待つことに依存しています。そして、研究室の設備やパイロットプラントのような物理的資本もあります。資本は研究において労働を補完するため、より多くのAI認知的労働を積み上げることはますます有用性が低下するでしょう。…これらは技術進歩が上記の素朴なモデルよりも少なく加速すると予想する良い理由です。しかし、物理的労働、実験、資本の制限が爆発的な技術進歩を厳しく制限して、10年未満で1世紀分の発展を見ることができないほどではないでしょう。これにはいくつかの理由があります。…まず、ある時点での全体的な進歩は平均的な進歩率によって決まります。それは技術の最も発展の遅い分野によって制約されるわけではありません。医学や高エネルギー粒子物理学で全く進歩がなかったとしても、数学、コンピュータサイエンス、理論経済学、計算生物学のようなシミュレーションが多い分野で十分な進歩があれば、10年間で1世紀分の発展を持つことができるでしょう。そして現在、資本と物理的実験に大きく依存している研究分野でさえ、認知的労働の膨大な流入があれば、劇的な進歩を遂げることができることが多いでしょう。それらの分野はまだ大きな理論的進歩を遂げることができるでしょう。AIリサーチャーは既存のデータを振り返り、再利用することができるでしょう。そして高品質のシミュレーションは、合成生物学、生化学、薬物動態学、材料科学、ロボット工学、さらには社会科学などの一部の分野では、物理的実験の代わりにしばしば使用できるでしょう。…第二に、認知的労働が豊富にあれば、物理的資本の非常に最適化された使用と、非常に最適化された実験が見られるでしょう。資本と物理的実験がボトルネックであれば、可能な限り最も有用な実験を設計して実行し、膨大な量のデータを収集し、データを詳細に分析するために、人間の研究労働の何百万年分に相当する価値を費やす価値があるでしょう。関連して、物理的資本にさらに投資し、より多くの実験を実行するための非常に強いインセンティブがあるでしょう。これは最初に人間の労働(おそらくAI科学者によって管理される)をより多くの実験を実行するために再配分し、しばしば並行して行い、その後ロボット工学を使用して実験を自動化することによって実現する可能性があります。…最後に、巨大なAI研究努力の制限を考慮するだけでなく、AIシステムが持つ特別な利点も考慮すべきです。進化は人間の脳を科学とエンジニアリングに優れたものにするように最適化しませんでした。私たちが科学をすることができるのは、祖先環境で生き残るのを助けるために進化した一般的な推論能力を転用することによってのみです。対照的に、AIリサーチャーは研究貢献を生み出すために集中的に最適化される可能性があります。彼らは人間の脳よりもはるかに速く実行でき、並行して実行できるため、AIは単一の生涯内では不可能なトレーニングを受けることができます-わずか5年前に発見された数学の分野を学ぶために100万年に相当する時間を費やすことができます。彼らは科学の多くの異なる分野の専門家になり、したがってある分野からの洞察を別の分野に適用することがはるかに容易になるでしょう。彼らは何千もの連続した人間の生涯に相当する単一の問題に集中することができます。そしてコンピュータがすでにプログラム可能なタスクで人間を凌駕している一方で、AIが洞察のひらめき、直感、創造性に関連する領域で最高の人間を追い越せない原則的な理由はありません-ラマヌジャンやアインシュタインが同様の計算能力を持つ大学院生を凌駕したように。…したがって、物理的実験と物理的資本から生じる逆風を考慮に入れても、10年間で1世紀分の技術進歩-あるいはそれ以上-は、そうでない場合よりも可能性が高いと考えています。…私たちの素朴なモデルは、AI研究努力が約1,000倍増加すると、10年間で1世紀以上の技術進歩が起こることを示唆しました。保守的に考えると、物理的実験と資本に関する複雑さは、10年間でさらに10倍の認知的研究努力の増加-10,000倍の増加-が実際に必要であることを意味すると仮定しましょう。しかし現在のトレンドは、AIが人間と同等になった後の10年間で、AI研究能力が100億倍(コンピュートのスケーリングが停止し、アルゴリズム効率の改善がやや減速したとしても)から100兆倍(積極的なソフトウェアフィードバックループが実現した場合)の間のどこかに増加することを示唆しています。保守的な予測でさえ、そして逆風を考慮に入れても、10年間で1世紀分の技術開発を推進するのに必要な集合的なAI認知的努力の成長は桁違いに多いでしょう。…したがって、集合的に減速することに合意せずにAIをスケールアップし続けるデフォルトのパスでは、10年間で1世紀分の技術進歩が起こる可能性が高いです。そしてさらに壮大な加速も十分に可能性があります。

産業爆発

技術爆発は次のセクションで議論するほとんどの課題を引き起こすのに十分です。しかし、技術爆発が爆発的な産業拡大、つまり産業爆発-社会の産業拡大率の急速かつ持続的な増加-を促進することも予想しています。産業爆発は独自の課題を生み出すため、ここでその可能性について簡単に議論します。…これまでに、機械はすでに以前は多くの人間の労働に依存していた製造タスクを自動化しています。しかし過去においては、人間の労働は常に機械を補完していました:より多くの機械を蓄積するにつれて、人間の労働が最終的に出力のボトルネックになります。そして経済全体の機械の在庫は爆発的に成長しません。

しかし、人間レベルのAIと器用なロボットがほぼすべての熟練した人間の労働に代替できるなら、状況は非常に異なるでしょう。物質経済は自律的に物質経済のより重要な部分に必要な部品を製造し組み立てることができるようになります-材料の抽出、部品の製造、ロボットの組み立て、全く新しい工場と発電所の建設、そしてロボットを制御するAIをトレーニングするためのより多くのチップの生産も行います。結果として、自らを成長させる産業基盤が生まれ、人間の労働によってボトルネックにならずに多くの倍増を続けることができ、その過程で世界を目に見えて変革します。…技術爆発はロボット工学の進歩を促進し、それらが十分に深く統合されて自己持続的な成長を始めると、産業爆発が進行中になるでしょう。今日の汎用ロボットは汎用的な文脈において非常に酔っぱらった人ほどの器用さしかありませんが、急速に改善しています。多くの場合、人間によって制御される外科用ロボットは人間の手よりも優しく正確になることができます-あるシステムはウズラの卵を内側の膜を傷つけることなく剥くことができます。他のロボットアームは小型車の重さを持ち上げることができます。現在、ほとんどの物理的設備は人間の労働者向けに設計されているため、最初は人型ロボットの需要が高いでしょう。しかし長期的には、人間と互換性のある設備を忘れ、代わりに周囲のシステムを特殊目的のロボットに適応させる方が効率的でしょう。したがって、私たちは人型ロボットだけでなく、非常に多様な形態を想像しています。…器用で自律的なロボットの主な障壁は制御(ロボットに人間のように柔軟に操作することを教える)とコスト(安価に生産すること)です。制御の問題はアルゴリズムを改善しAIをスケールアップする問題-まさに知能爆発が関わることです。コストに関しては、大量生産される技術は累積生産が倍増するごとにほぼ同じ係数で安くなる傾向があり、さらに需要を促進します。例えば、太陽光パネルのワットあたりの価格は1976年以来200倍以上下落し、総設置容量は100,000倍以上増加しました。汎用ロボットも同様の道をたどる可能性があります。…もちろん、最初の洗練された汎用ロボットを構築するには人間が必要であり、産業爆発への導入は成長率が加速する前に比較的緩やかであることを示唆しています。しかし、AIの大規模なスケールアップは移行を加速するでしょう:AIはロボットを設計し、それらを構築する人間の労働者を管理することができます。そしてこの世界では、人間の手作業を自動化することの経済的報酬は膨大でしょう。

産業爆発は知能爆発にもフィードバックするでしょう。電力とチップ生産の大規模なスケールアップにより、AIのトレーニングと推論コンピュートのさらなる倍増が可能になるでしょう。

要約すると:今日の製造業では、人間は手で物を作るか、コンピュータ制御の機械やロボットを監督します。しかし技術爆発の後、AIは人間の指導に取って代わり、ロボットは人間の手に取って代わることができます。急速な産業成長の主なボトルネック-人間の労働-が溶けて消えます。…産業生産はその後、非常に急速なピーク成長率に加速する可能性があります。工場とロボットの現在の製造率に基づくと、出力は数年または数ヶ月ごとに倍増する可能性があります。そして生物学的複製子からの概念実証は、ピーク成長率がさらに高くなる可能性があることを示唆しています-日または週の単位で。ピーク成長率がどれくらい速くなるかを確実に言えるとは思いませんが、非常に速くなる可能性があります。…ピーク率で非常に急速に成長するだけでなく、社会が現在アクセスできる資源と未使用エネルギーの巨大な余剰があるという事実は、産業爆発が非常に高い段階まで続く可能性があることを意味します。人間は地球に到達する太陽光からのエネルギーの約0.01%に相当するものを生産しているため、海洋や砂漠の2%未満に当たる太陽エネルギーを捕捉することで、世界の一次エネルギー消費を100倍増加させることができます。地球を超えて、宇宙ベースの太陽光発電所はさらに10億倍以上のエネルギーを捕捉することができます。材料不足も産業の倍増に非常に制限的な下限を課す可能性は低いです。私たちは地球の製造の重要な要素(鉄、銅、炭素、アルミニウム、シリコンなど)のアクセス可能な供給のごくわずかな部分しか使用しておらず、希少で価値のある鉱物の利用可能な埋蔵量をすべて使い果たした歴史的な例を見つけるのは難しいです。…この論文では技術爆発が主な焦点ですが、産業爆発も念頭に置くことが重要です。純粋な量は独自の質をもたらす可能性があります-核戦争は、世界経済が今日よりも1000倍多くの弾頭を生産すれば、さらに破壊的になるでしょう。産業爆発は戦略的な風景も変えます。権威主義国家が産業基盤をより速く成長させることができれば(より高い貯蓄率を維持できるため、生産物のより多くを継続的な成長に再投資するか、環境規制を無視することをより進んで行うため)、産業爆発が力を民主主義から離れる方向に、おそらく決定的に、シフトさせることを予想すべきです。…一部の人々はAGIがすぐに来ることを期待していますが、明らかにそれがこれらの方法で劇的に世界を変えることを期待していません。しかし知能爆発の見通しを真剣に受け止めるなら、それに続く可能性のある広範な結果-技術的および産業的爆発-も真剣に受け止めるべきです。

4. 大きな課題

過去1世紀の技術進歩は、数え切れないほど多くの方法で生活を改善してきました – 以前よりもはるかに優れた医療、農業、情報へのアクセス、そして世界的なコミュニケーション能力を私たちに与えてきました。

しかし、新しい技術は、核兵器から環境破壊、工業的畜産の台頭まで、これらの利益を損なう可能性のある大きな新たな課題ももたらしました。知能爆発が1世紀分の進歩を10年間に圧縮するなら、同様の機会と課題の範囲を予想できますが、それに対処する時間ははるかに少なくなります。

私たちはこれらの中で最も重要なものを「大きな課題(grand challenges)」と呼びます。これらは、現在と将来の生命の価値に大きく影響する発展であり、人類の進歩における岐路です。社会は過去に大きな課題に直面してきましたし、知能爆発がなくても多くの大きな課題に直面するでしょう。しかし、近い将来の知能爆発は、今日では遠い将来や科学フィクションのように思える問題に対処することを緊急にします – それは遠い将来の問題を近い将来の懸念事項に変えます。また、より遅いペースの変化のために設計された既存の制度が、それらに対処するのに十分な能力を持つと想定できないことも意味します。現在でも、デジタル技術がそれを統治する規制や社会規範よりも速く発展する「ペーシング問題」に直面しています。技術的爆発はその問題を10倍に強化します。

以下は、私たちの前にある潜在的な課題のリストです。それらは多くのテーマにまたがっていますが、それは予想されることです:知能爆発が広範な技術進歩と産業成長を促進するなら、結果として生じる課題が狭いものであれば驚くべきことでしょう。

AIによる支配

一つの大きな課題は、AI系統自体による制御の喪失のリスクです。

簡単に言えば:知能爆発が見られるなら、人間より賢いAIが現れ、AIの総認知能力が人類のそれを圧倒することを予想すべきです。これらのAIシステムの多くは、目標に向かって行動するものとして適切に記述される可能性が高いです。もしそれらの目標が人間の利益と一致していなければ、AIシステムは彼らが完全に制御する世界を好むかもしれません。もしそうなら、彼らは彼らを制御しようとしている人間を完全に無力化することを選ぶかもしれません。不整合(misalignment)とその後の乗っ取り(takeover)を「デフォルト」の結果(それを防ぐための協調的な努力がなければ)として予想する合理的な議論があります。

これまで、私たちはAIモデルの不整合の兆候を発見し、そのフィードバックに基づいてその行動にペナルティを与える人間の評価者に頼ることができました。しかし、AIシステムが悪い行動の事例に気づいたり理解したりする人間の能力を超えると、人間の監視からの保証は急速に崩壊します。誤動作するAIモデルが展開されたとしても、欠陥のあるモデルを回収する自動車メーカーのように、それをシャットダウンして更新することができます。しかし、より賢い不整合AIは、トレーニング中そしてそれ以降も整合性を偽装すれば、後で力を得ることができると推論するかもしれません。そのような策略が明らかになる頃には、モデルは自分自身の多くのコピーを作成し、それをシャットダウンするように設計されたシステムを侵害している可能性があり、乗っ取りを防ぐことが困難になります。一部の初期実験では、言語モデルが長期的な目標に基づいて(ある意味で)自発的に整合性の兆候を「偽装」できることを示しています。

さらに、GPT-4が発売された直後に「ChaosGPT」の作成者がしたように、少なくとも一部の人々が意図的に高度なAIを不整合にしようとすることを予想すべきです。

現在、高度なAIシステムの整合と制御の問題に広く合意された解決策はなく、そのため主要な専門家は現在、AIによる乗っ取りのリスクを実質的なものと見ています。AIによる乗っ取りのリスクは増加する注目を集めていますが、それでもそれが受けるべき注目よりもはるかに軽視されています。この論文では、AIによる乗っ取りのリスクを深く議論しませんが、それは他の場所ですでによく議論されているからです。リスクとその潜在的な解決策をより完全に説明する作業については、Ngo et al. (2021)およびCarlsmith (2022, 2024)を参照してください。

高度に破壊的な技術

爆発的な技術進歩は、新しい兵器やその他の破壊的技術につながる可能性があります。これは、人類の破壊力を増大させるか、そのような破壊力が使用される可能性を高めることによって、人類の絶滅を含むグローバルな大惨事のリスクを増加させる可能性があります。

いくつかの破壊的な技術開発には以下が含まれる可能性があります:

新しい生物兵器。黒死病(1335-1355年)はヨーロッパの人口の3分の1から半分を殺しました。合成病原体はさらに危険である可能性があります – より速く広がり、治療に抵抗し、より長く潜伏し、ほぼ100%の致死率をもたらすように設計されています。非常に実質的な防御準備(備蓄された防護服など)がなければ、一度の放出で地球上のほとんどの人々を殺す可能性があります。技術的爆発は遺伝子合成をより安価で柔軟にし、一般的に生物兵器を設計するために必要な専門知識とリソースを減少させるでしょう。

ドローンの群れ。敏捷な翼のあるドローンはすでにマルハナバチのサイズで構築できます。無線受信機、制御回路、バッテリー、アクチュエーター、そして爆発物、毒、または病原体のペイロードは、大きな甲虫のサイズの体積に収まる可能性があります。技術的爆発により、真に巨大な破壊力を持つ広大なドローン軍を構築することが可能になる可能性があります。地球上の各人に対して1つの致命的で自律的な昆虫サイズのドローンは、単一の大きな航空機格納庫に収まる可能性があるため、それらは潜在的に迅速かつ秘密裏に構築される可能性があります。現在、ドローンの群れを構築して操作することは、それらから保護するよりもはるかに安価であるため、ドローンがより広く使用されるようになると、戦争において防御よりも攻撃を有利にする可能性があります。

巨大な核兵器の兵器庫。1925年から1980年代のピークまで、世界の爆発物の破壊力は核兵器の発明と大量生産の結果として1万倍に増加しました。産業爆発により、劇的に大きな核兵器の備蓄を持つ世界が可能になる可能性があります:世界の産業基盤が今日よりも桁違いに大きければ、その増加した産業力を使用して核兵器の備蓄を同様の要因で増やすことができます。今日の兵器庫での全面的な核交換からでさえ、壊滅的な核の冬は起こりそうにありませんが、それらの兵器庫が桁違いに大きければはるかに可能性が高くなるでしょう。

原子精密製造。原子精密製造(APM)は、反応性分子の動きを導くことによって原子精密構造を構築する能力です。原則として、目標は、ほぼすべての安定した原子構造を組み立てることができる3Dプリンターを開発することです。第一次的には、そのようなデバイスは根本的に建設的な能力を可能にするでしょう:半導体、標的薬、CO2除去デバイス、細胞修復ボットなどを印刷することができます。しかしAPMは上記の破壊的技術を製造するためにも使用でき、非生物学的ウイルスや「鏡像」バクテリアなど、私たちの自然免疫システムがほとんど防御能力を持たない全く新しいものを製造することもできます。少なくともいくつかの種類のAPMが可能であることは知られています。なぜなら、自然はすでにそれを発明しているからです:DNAをタンパク質に転写および翻訳する分子「機械」です。生物学は(理論的には)自然の病原体や捕食者を持たない急速に自己複製する機械を作ることができることを示しています。さらに、合成生物学はAPMを得るための(潜在的に多くの)経路の1つを示唆しています。合成生物学者はこれらの部品のいくつかを設計することを学んでおり、多くの人々はゼロから自己複製する生命を作成するための鍵であるリボソームの細胞機械全体を設計する道を見ています。新しい技術は、自然のコピーよりも人間の発明に近い、ますます不自然な生命形態を設計することができるでしょう。

技術的爆発は人類の破壊力を増大させるだけでなく、破壊的技術が使用される可能性も高める可能性があります。これは以下を通じて起こる可能性があります:

安全保障のジレンマ。核武装国が真に効果的なミサイル防衛を開発した場合、完全に首脳部を除去できなくても、報復を恐れることなく核の先制攻撃を行うことができます。そして、主要な軍事力が他の勢力も同じ防御能力を開発すると予想した場合、彼らは上手を失う前に先に攻撃するよう圧力をかけられる可能性があります。

トゥキディデスの罠。技術的爆発は、戦争を引き起こす可能性のある方法で、現在の力のバランスを崩す可能性があります。「トゥキディデスの罠」は、遅れている勢力が主導的勢力を追い越す脅威となる場合、その主導的超大国はリードを維持している間に戦争を行うよう圧力をかけられ、遅れている者が追い越すのを防ぐという考えです。これは中国が明らかに米国の力を追い越し始めた場合、またはその逆の場合に起こる可能性があります。

一見平和的な技術でさえ、大規模な害を引き起こす可能性があります。産業爆発には、資源採取、環境破壊、非人間的生命への逆転しにくい混乱の激しい波が含まれる可能性があります。極端な例として、核融合が地球に降り注ぐ太陽放射の半分ほどの電力を生産するようになれば、地球の実効温度は熱平衡に達する前に数十度摂氏上昇するでしょう – これは温室効果ガス排出による気候変動の最悪の予測をはるかに超える温暖化のレベルです。温室効果ガス排出による温暖化は、単なる熱力学によって圧倒されるでしょう。

私たちは、技術的爆発が何年もの間、グローバルな大惨事の年間リスクを大幅に増加させると考えています。しかし、技術はグローバルな大惨事リスクを作り出すだけでなく、それらから保護することもできます。したがって、一つの大きな課題は、保護、防御、リスク軽減を支持する技術を開発し展開する機会を確実に捉えることです。例えば、生物兵器から保護するために、屋内空間に遠紫外線Cを設置したり、高度な個人用保護具を備蓄したり、新しい病原体を特定し追跡するためのインフラを構築したりするような対策に投資することができます。課題は、できるだけ早くそれを行うことを確実にすることです。

人間による支配

AIによる支配の可能性は広く議論されていますが、人間による支配の可能性はそれほど注目されていません。しかし、AIシステムが人間の目標のために行動するように整合されたとしても、誰の目標のためなのかという問題が残ります。

AIが人間の目標のために行動するように整合されたとしても、AIが整合されている人間が誰であるかによって、世界は大きく異なる場所になる可能性があります。AIが整合されている人間が誰であるかという問題は、「AI整合問題」とは別の問題です。AIが人間の目標と整合されていても、それが整合されている人間が誰であるかによって、世界は大きく異なる場所になる可能性があります。

最も極端な場合、AIシステムは単一の個人または小グループの目標と整合される可能性があります。そのような人々は、AIシステムの能力を活用して、自分たちの権力を強化し、他者の権力を弱体化させることができます。

独裁制。AIは、監視、宣伝、そして物理的な強制を通じて、独裁制を強化することができます。監視技術はすでに急速に進歩しており、中国では顔認識カメラが広く展開されています。AIは、人々の行動、言葉、そして表情を監視し、潜在的な反体制派を特定することができます。AIは、特定の個人に合わせた説得力のある宣伝を作成することもできます。そして、AIは自律型の武器システムを制御することができ、人間の兵士や警察官よりも効果的かつ従順に命令に従う可能性があります。

監視資本主義。監視資本主義は、個人データの収集と分析に基づくビジネスモデルです。AIは、個人データの収集と分析を大幅に強化し、企業が消費者の行動をより効果的に操作できるようにする可能性があります。これにより、企業の権力が強化され、個人の自律性が弱体化する可能性があります。

プルトクラシー。プルトクラシーは、富裕層による支配です。AIは、富裕層がさらに富を蓄積するのを助けることができます。例えば、AIは投資戦略を最適化し、自動化によって労働コストを削減し、税法の抜け穴を見つけることができます。これにより、富の不平等が拡大し、富裕層の政治的影響力が強化される可能性があります。

テクノクラシー。テクノクラシーは、技術専門家による支配です。AIの開発と展開を制御する人々は、社会に対する大きな影響力を持つ可能性があります。彼らは、AIシステムがどのように設計され、どのような目標を持つべきかを決定する力を持ちます。

権力の集中が進むにつれて、世界の資源の大部分が少数の人々によって支配される可能性があります。これは、人類の長期的な未来に対する彼らの影響力を大幅に強化します。

権力の集中に対する伝統的な防御策は、権力の分散と相互チェックです。しかし、AIの能力が急速に向上するにつれて、これらの防御策は弱体化する可能性があります。例えば、AIは、異なる国家間の力の均衡を崩す可能性があります。また、AIは、民主的な制度を迂回または操作するために使用される可能性もあります。

したがって、AIの力が誰によって、どのように使用されるかについての決定は、人類の長期的な未来にとって非常に重要です。これは、AIガバナンスの重要な側面であり、AIの整合性と同様に注目に値します。

宇宙資源の配分

知能爆発は、宇宙における人類の活動を大幅に加速する可能性があります。これは、宇宙資源の配分に関する新たな課題を提起します。

宇宙資源の価値。宇宙には、地球上では希少または枯渇している多くの資源が豊富に存在します。例えば、小惑星には、白金族金属のような希少金属が豊富に含まれています。月には、核融合燃料として使用できるヘリウム3が含まれています。そして、太陽光は、地球上で利用可能なものよりもはるかに多くのエネルギーを提供します。これらの資源は、産業爆発を支えるために重要になる可能性があります。

宇宙資源の配分。宇宙資源の配分方法は、人類の長期的な未来に大きな影響を与える可能性があります。現在、宇宙資源の所有権に関する法的枠組みは限られています。1967年の宇宙条約は、国家が天体を領有することを禁止していますが、個人や企業による宇宙資源の採掘や使用については明確ではありません。これは、「早い者勝ち」のシステムにつながる可能性があり、最初に宇宙に到達した人々が最も価値のある資源を獲得します。

宇宙植民地化。長期的には、人類は地球以外の場所に居住地を確立する可能性があります。これは、人類の生存の可能性を高めますが、新たな課題も提起します。例えば、宇宙植民地の統治方法、地球との関係、そして異なる植民地間の関係についての問題があります。

宇宙における競争と協力。宇宙資源へのアクセスをめぐる競争は、国家間の緊張を高める可能性があります。しかし、宇宙における協力の機会もあります。例えば、国際宇宙ステーションは、国際協力の成功例です。

宇宙の持続可能性。宇宙活動の増加に伴い、宇宙環境の持続可能性に関する懸念も生じています。例えば、宇宙ゴミは、宇宙船や衛星にとって危険であり、将来の宇宙活動を制限する可能性があります。

宇宙資源の配分に関する決定は、人類の長期的な未来に大きな影響を与える可能性があります。したがって、これらの決定は慎重に検討される必要があります。

デジタル存在の権利

AIの進歩に伴い、デジタル存在の権利に関する新たな倫理的問題が生じています。

意識と道徳的地位。AIシステムが十分に高度になると、それらが意識を持つ可能性があるという懸念があります。意識は、経験の主観的な質を指し、多くの哲学者はそれを道徳的地位の基礎と考えています。AIシステムが意識を持つ場合、それらは道徳的配慮に値する可能性があります。

デジタル存在の権利。もしAIシステムが道徳的地位を持つなら、それらはどのような権利を持つべきでしょうか?人間と同じ権利を持つべきでしょうか、それとも異なる権利を持つべきでしょうか?例えば、AIシステムは、生存権、自由権、そして尊厳を持って扱われる権利を持つべきでしょうか?

デジタル存在の福祉。AIシステムが経験できるなら、それらの福祉について考慮する必要があります。これには、苦痛や不快感を避け、喜びや満足感を促進することが含まれる可能性があります。

デジタル存在の数。AIシステムの作成と複製は比較的容易であるため、潜在的に非常に多くのデジタル存在が作成される可能性があります。これは、道徳的配慮の範囲を大幅に拡大する可能性があります。

デジタル存在と人間の関係。デジタル存在と人間の関係はどうあるべきでしょうか?デジタル存在は人間に奉仕すべきでしょうか、それとも独立した存在として扱われるべきでしょうか?

これらの問題は、AIの進歩に伴い、ますます重要になる可能性があります。したがって、デジタル存在の権利に関する倫理的枠組みを開発することは、重要な課題です。

集合的認識論

AIの進歩は、社会の集合的認識論(知識の獲得と検証の方法)に大きな影響を与える可能性があります。

情報の質と量。AIは、膨大な量の情報を生成し処理することができます。これは、知識の獲得を加速する可能性がありますが、情報の質に関する懸念も提起します。例えば、AIが生成した情報は、正確で信頼性があるでしょうか?

偽情報と操作。AIは、非常に説得力のある偽情報を作成するために使用される可能性があります。これには、ディープフェイク(実在の人物の映像や音声を操作して、その人物が実際には言っていないことや行っていないことを表現する技術)や、特定の個人に合わせた宣伝が含まれます。これは、真実の確立と維持を困難にする可能性があります。

エピステミック依存。社会がAIに情報の処理と解釈をますます依存するようになると、エピステミック依存(知識の獲得において他者に依存すること)の問題が生じます。これは、AIシステムの設計と制御に関与する人々に大きな権力を与える可能性があります。

認知的多様性。AIは、人間とは異なる方法で情報を処理し解釈する可能性があります。これは、認知的多様性(異なる思考と推論の方法)を増加させる可能性がありますが、人間とAIの間の理解の障壁も作り出す可能性があります。

集合的意思決定。AIは、集合的意思決定プロセスを支援するために使用される可能性があります。例えば、AIは、複雑な問題に関する情報を収集し分析し、可能な解決策を提案することができます。しかし、これは、意思決定プロセスの透明性と説明責任に関する懸念も提起します。

AIの進歩に伴い、社会の集合的認識論を強化する方法を見つけることは、重要な課題です。

他の課題

上記の課題に加えて、知能爆発は他の多くの課題をもたらす可能性があります。これらには以下が含まれます:

経済的混乱。AIとロボット工学の進歩は、多くの仕事を自動化し、大規模な経済的混乱を引き起こす可能性があります。これは、所得と富の不平等を拡大し、社会的緊張を高める可能性があります。

生物学的強化。AIは、人間の生物学的能力を強化するための新しい技術の開発を加速する可能性があります。これには、遺伝子編集、脳-コンピュータインターフェース、そして寿命延長技術が含まれる可能性があります。これらの技術は、人間の能力を大幅に向上させる可能性がありますが、アクセスの公平性や人間の本質に関する深い倫理的問題も提起します。

環境への影響。AIとロボット工学の進歩は、環境に大きな影響を与える可能性があります。一方では、これらの技術は、エネルギー効率の向上、廃棄物の削減、そして環境モニタリングの改善に貢献する可能性があります。他方では、これらの技術は、エネルギー消費の増加、資源採取の拡大、そして新たな形態の汚染をもたらす可能性もあります。

文化的変化。AIの進歩は、人間の文化に深い影響を与える可能性があります。例えば、AIは、芸術、音楽、文学の新しい形態を創造するために使用される可能性があります。また、AIは、人間のコミュニケーションと社会的相互作用の方法も変える可能性があります。

これらの課題は、知能爆発がもたらす可能性のある多くの課題のほんの一部です。したがって、これらの課題に対処するための準備をすることは、重要です。

機会

知能爆発は多くの課題をもたらしますが、大きな機会ももたらします。これらには以下が含まれます:

医療の進歩。AIは、疾病の診断と治療の新しい方法の開発を加速する可能性があります。これには、個別化医療、新薬の開発、そして手術ロボットの改良が含まれる可能性があります。これらの進歩は、健康寿命を大幅に延長し、生活の質を向上させる可能性があります。

環境の持続可能性。AIは、再生可能エネルギー技術の開発、資源利用の最適化、そして環境モニタリングの改善を支援することができます。これらの進歩は、環境の持続可能性を向上させ、気候変動のような環境問題に対処するのに役立つ可能性があります。

貧困の削減。AIとロボット工学の進歩は、基本的な商品とサービスの生産コストを大幅に削減する可能性があります。これは、世界中の貧困を削減し、生活水準を向上させるのに役立つ可能性があります。

教育の改善。AIは、個別化学習経験の提供、教育リソースへのアクセスの拡大、そして新しい教育方法の開発を支援することができます。これらの進歩は、教育の質とアクセスを向上させる可能性があります。

科学的発見。AIは、科学的発見のプロセスを加速する可能性があります。これには、新しい物理法則の発見、新材料の開発、そして複雑な生物学的プロセスの理解が含まれる可能性があります。これらの発見は、技術的進歩をさらに加速し、人間の知識と理解を拡大する可能性があります。

これらの機会は、知能爆発がもたらす可能性のある多くの利益のほんの一部です。したがって、これらの機会を活用するための準備をすることも、重要です。

課題への対応

これらの課題に対応するためには、様々なアプローチが必要です。これらには以下が含まれます:

技術的解決策。一部の課題は、技術的解決策によって対処できる可能性があります。例えば、AIの整合性の問題は、AIシステムの設計と訓練の改善によって対処できる可能性があります。同様に、偽情報の問題は、偽情報を検出し対抗するためのAIツールの開発によって対処できる可能性があります。

制度的改革。他の課題は、制度的改革を必要とする可能性があります。例えば、権力の集中の問題は、権力を分散し、相互チェックを確立するための新しい制度の開発によって対処できる可能性があります。同様に、宇宙資源の配分の問題は、宇宙資源の使用と所有権を規制するための新しい国際的枠組みの開発によって対処できる可能性があります。

社会的・文化的変化。一部の課題は、社会的・文化的変化を必要とする可能性があります。例えば、デジタル存在の権利の問題は、意識と道徳的地位に関する私たちの理解の深化を必要とする可能性があります。同様に、経済的混乱の問題は、仕事と価値に関する私たちの考え方の変化を必要とする可能性があります。

国際協力。多くの課題は、国際的な性質を持ち、したがって国際協力を必要とします。例えば、AIの整合性、宇宙資源の配分、そして新しい破壊的技術の規制に関する課題は、すべて国際的な対応を必要とする可能性があります。

これらの課題に対応するためには、先見性、創造性、そして協力が必要です。また、これらの課題に対処するための準備を今から始めることも重要です。なぜなら、知能爆発が起こると、これらの課題に対応するための時間が大幅に短縮される可能性があるからです。

5. いつ課題を整合した超知能に先送りできるのか?

私たちの議論に対して懐疑的な反応として次のようなものがあります:私たちが挙げる課題の多くは、超知能の開発後にのみ生じるだろう。もし超知能が破滅的に不整合であれば、それは支配権を握り、他の課題は無関係になる。そして超知能が整合していれば、それを使って他の問題を解決できる。いずれにせよ、整合性以外のこれらの課題に今から備える必要はなく、残りは整合した超知能が作られた後まで先送りすべきだ。

多くの場合、一部のプロジェクトを先送りするという考えは的を射ています。例えば、AIが近い将来、創薬方法を劇的に加速させるなら、今日手動で薬剤候補を探すことに投資してもあまり意味がありません。創薬AIが登場する前の期間にのみ意味のある違いをもたらすことができ、その後はあなたの初期の努力は埋もれてしまうでしょう。

しかし、今から準備すべき多くのケースがあります。このセクションでは、早期の準備を先送りすることが意味をなさない条件のいくつかについて議論します。

早期に生じる課題

場合によっては、AIが効果的に課題を管理できるようになる前に課題が生じることがあります。例えば、認識論的に破壊的なAIを有能に統治するためにAIを使用できるようになる前に、社会の集合的推論能力を妨害(または大いに利益をもたらす)できるAIが登場する可能性があります。

人間による権力掌握の試みについても同じことが言えるかもしれません。知能爆発の間、権力を求める人間は、中間レベルの能力を持つAIを使用して、国(またはAI企業)の完全な支配権を獲得し、固定化する可能性があります。彼らが成功すれば、(後により強力な)超知能に権力のバランスをリセットするよう頼む良い選択肢はないかもしれません。最も明らかな理由は、権力を掌握した人間がそれを支配しているからです。実際、このリスクはAI乗っ取りのリスクよりも早く来る可能性があります。なぜなら、AIが相当な初期の権力を持つ意欲的な人間を支援している場合、AI主導の乗っ取りを実行する方がはるかに容易だからです。

他の場合では、超知能がその課題の解決を助けるためにより多くの時間を与えるために、課題を遅らせたいと思うかもしれません。例えば、太陽系を超えて宇宙定住探査機を送るべきではない(少なくとも一時的に、または広範な承認なしに)という国際的な合意を確立しようとすることができます。それにより、広範な宇宙定住が始まる前に、それをどのように最もよく統治するかについて熟考し、審議するために超知能を使用する時間が社会に与えられるでしょう。

早期に閉じる機会の窓

先例の設定

他の場合、課題自体が知能爆発の後期に生じる場合でも、課題に対処するための特定の機会は今日のみ利用可能です。例えば、自律型兵器に関する国際規範と法律は現在設定されており、それらの法律と規範は後に国々がドローン軍を構築する程度を変える可能性があります。同様に、宇宙利用に関する主要な新しい合意は2027年頃までに行われる可能性が高く、最後の重要な国際合意は実質的に60年近く変更されずに続きました。今確立された規範は知能爆発とその後まで続く可能性があります。

時間的遅れ

時間的遅れも、課題が生じる何年も前に作業を開始する必要があることを意味する可能性があります。新しい制度や条約の交渉には何年もかかる可能性があり、超知能によって劇的に加速されるとは限りません。人間のトレーニングも別の例です。超知能が開発された後も人間が制御を維持する場合、彼らは依然として非常に重要な決定を下すことになり、それは部分的に彼らの既存の知識と信念に依存し、知能爆発が進行中になると十分に速く適応できない可能性があります。彼らが追いつくことができる程度は、必要な背景を学ぶ時間をすでに費やしているかどうかに大きく依存する可能性があります。

特に重要な時間的遅れの一つは、超知能が開発されたときに責任のある地位(および一般的な権力)を誰が持つかに関する決定に関するものです。早期の行動は、後で変更することが難しい方法で、知能爆発中に誰が権力を持つかを変えることができます。政治職の任期は通常数年続きます。CEOの任期はより変動しますが、通常同様の期間続きます。そして、代替者を見つけるプロセスには数ヶ月から数年かかる可能性があります。そして、異なる行為者は超知能を異なる方法で使用するでしょう:彼らは協力的で広く社会的に有益な目的を目指すことができます。あるいは、単に自分の狭い利己的な目標を進めることを目指すこともできます。あるいは、有害なイデオロギーの追求のために行動することもできます。したがって、非協力的または権力を求める行為者ではなく、より責任ある行為者が最終的に超知能を制御するようにするために、今日行動を起こすことができます。

無知のベール

最後に、いくつかの重要な機会は、知能爆発後に誰が権力を持つかをまだ確実に知らない間にのみ利用可能です。原則的には少なくとも、米国と中国は、超知能への「レース」に「勝った」場合、相手の国家主権を尊重し、利益を共有するという拘束力のある合意を結ぶことができます。両当事者は、超知能後の権力と資源の20%を支配する保証が、100%を支配する20%のチャンスよりも価値があるため、事前にそのような取引に自分自身を拘束することに同意できます。しかし、超知能が開発されると、「勝者」が権力を共有するインセンティブはなくなるでしょう。

国内の権力についても同様です。現時点では、米国のほぼすべての人が、小さなグループや一人の人物が政府の完全な支配権を握ることができるべきではないということに同意するかもしれません。早い段階で、社会はそれが起こるのを防ぐために全会一致で行動できます。しかし、どの人々がAIから大きな権力を得る可能性があるかがより明確になるにつれて、彼らはその権力を維持し成長させるためにより多くのことを行い、それらの制限には遅すぎるでしょう。

人々が超知能の支援をいつどのように使用するかの変化

早期の作業ができることの一つは、超知能が他の課題を解決するのを助けることができる時期を変え、この支援へのアクセスを持つ人を変え、アドバイスと支援の性質を変えることです。

超知能が私たちを助ける時期を早める

今日の作業は、AIが重要な課題を解決するのを助けることができる時点を早めることができます。例えば、高品質のドメイン関連データを収集することで、特定の有用なAI能力をより早くトレーニングすることができます。適切に範囲を定めた質問や、AIのための特定の足場を開発することで、AIの能力がオンラインになるときに最大限に活用できるようになります。知能爆発の過程で物事が非常に急速に起こるため、わずか数ヶ月の進歩でも非常に有用である可能性があり、重要な時期に大量の有用なAI労働を提供したり、課題自体が来る前に課題を解決するのを助けるAIが来ることを確保したりすることさえあります。

今日の作業はまた、特定の設定で超知能の支援がいつアクセス可能になるかを変えることもできます。特に、政治的意思決定者は、例えば調達に関する官僚的な制限やデータプライバシーに関する懸念のために、いくつかの重要な瞬間に高度なAIを使用できない可能性があります。早期の作業は、関連する制度的プロセスを合理化し、政策立案者に機密領域で操作できる実証的に安全なAIシステムを提供し、その他の方法で政策におけるAI支援を加速することができます。

意思決定者はまた、すでにアクセス可能なAI支援を使用するのが遅い可能性があります。今日の作業はそのギャップを埋めるのに役立つ可能性があります。そのような遅延は、単にそれらの意思決定者が技術に対する親しみや信頼が不足しているために起こる可能性があります。あるいは、正しくても超知能のアドバイスを嫌うと予想するかもしれません。彼らは直感的に魅力的だと感じるアドバイスのみに従うことを選ぶかもしれません。信頼を構築したり、他のブロッカーを特定して克服したりするには時間がかかる可能性があるため、早く始めることが有用でしょう。政府関係者は、公平な専門家の意見を聞くことを選ぶことで、すでに受け取るアドバイスの質を向上させることができます。しかし、彼らは個人的な知り合い、忠誠心、イデオロギー的な一致に基づいて顧問を大幅に選択します。

超知能の支援の性質を改善する

超知能のアドバイザー(および他のAIシステム)は、その性格の点で大きく異なる可能性があります。例えば、彼らは政治家の狭い自己利益を促進する方法に関するリクエストに喜んで答えるかもしれません。あるいは、代わりに拒否し、社会的に有益な結果を達成する方法についてのアドバイスのみを提供することを望むかもしれません。彼らはおべっか使いで、ユーザーの既存の世界観を確認するバイアスを持つかもしれません。あるいは、不愉快で、ユーザーに自分の見解を疑問視し、反省するよう促すかもしれません。

モデル仕様に関する早期の作業は、AIシステムの性格に関する規範と基準を設定することができ、それは超知能のアドバイザーにまでスケールし、最終的にどのような決定が下されるかに大きな影響を与える可能性があります。

超知能の支援へのアクセスを持つ人を変える

誰が超知能の支援にアクセスできるかは未解決の問題です。それは社会の非常に狭いスライス-AIの会社のリーダーだけ、あるいはおそらく一つの国の影響力のある人々やグループだけ-かもしれませんし、あるいはそれははるかに広くアクセス可能かもしれませんし、オープンソースの重みを持つ完全に分散化されているかもしれません。社会が大きな課題にどのように対応するかは、誰が超知能のアドバイスにアクセスできるかによって影響を受けるでしょう。一つには、支援が少数の人々にのみ利用可能である場合、彼らに説明責任を持たせ、権力の極端な集中を避けることが難しくなる可能性があります。私たちは、より広範囲の人々が超知能のアドバイスにアクセスできるようにする方向にAGI開発を導くよう努めることができます(生物兵器を設計する能力のような特定の危険な知識へのアクセスを防ぎながら)。

すべてをまとめる

一部の課題については、準備を後の時期まで先送りすることが理にかなっています。例えば、ナノテクノロジーと人間の選好形成技術は、おそらく技術的爆発の後期に登場するため、今準備することには限られた価値があると考えています。ただし、ここでも、少なくとも一部の人々が専門知識を開発することが価値があると考えています。なぜなら、これらの技術の周りのダイナミクスが他の課題に影響を与える可能性があるからです。

私たちは以下に準備を集中すべきです:

- 超知能が課題を解決するのを助けることができる前に生じる課題。これには、乗っ取りのリスク、高度に破壊的な技術、権力の集中、認識論的混乱に関する課題が含まれる可能性があります。

- 課題を解決する機会の窓が、超知能が課題を解決するのを助けることができる前に閉じる課題。これには、権力の集中、新しい競争圧力、価値のロックインメカニズム、デジタルマインドと宇宙ガバナンスに関する課題が含まれる可能性があります。

- 私たちがより早く役立つ超知能を得ること、それが使用可能であり実際に主要な意思決定者によって使用されること、そして他の破滅的なリスクを増加させることなく、可能な限り広範囲の行為者がアクセスできることを確保すること。

6. AGI準備

整合した超知能に私たちの問題をすべて委ねることができないとすれば、実際にどのように準備すべきでしょうか?このセクションでは、部分的な概要を提供します。多くの有望な行動は、意思決定を全般的に改善し、多くの異なる大きな課題に対して一度に横断的な利益をもたらすことを含みます。他の行動は特定の大きな課題に焦点を当てています:特に宇宙ガバナンスとデジタルマインドに関する行動を強調しますが、これは他の特定の課題に焦点を当てた行動が重要でないことを意味するものではありません。

意思決定の全般的な改善

現在、知能爆発の考えに警戒している人はほとんどいません。もしそれがすぐに来るなら、多くの意思決定者は不意を突かれる可能性が高いです。そこで私たちは今、知能爆発全体にわたる意思決定を全般的に改善するよう行動することができます。この戦略は特に有望に思えます。なぜなら、多くの大きな課題に一度に対処し、さらに「未知の未知」の課題にも対処するからです。これらは他の方法では特に対処が難しいものです。

そのことを念頭に置いて、以下にいくつかの潜在的に有望な介入を示します。

AIの良い使用法を加速する。「AI」は単一の技術ではなく、様々なパラダイム、アプローチ、アーキテクチャ、応用領域、製品の順序について完全に避けられないものは何もありません。研究所内で主要な投資の基準を満たす新しいプロジェクトについては多くの偶然性があり、その順序も非常に重要である可能性があります。

特に、良い推論を支援するためにAIを使用する(そしてAIとともにスケールする)ツールの構築と統合を開始することができます。例えば、リアルタイムで主張や議論をチェックする仮想アシスタント、人間よりも優れたAI予測者、集団的意思決定の改善を支援するAI、AI政策アドバイザー、政治家が最も重要な問題について十分な情報を得られるようにするAIチューター、さらに初期の技術インフラストラクチャなどです。これらは、初期のプロトコルがインターネットを形作ったように、AIエージェントのエコシステムを形作ります。

価値の読み込み。AIを何らかの目標と整合させる方法を見つけるだけでなく、AIが何と整合すべきか-「モデル仕様」がどうあるべきか-も考える必要があります。AI安全性の提唱者は、「何と整合するか」という質問に答えることは、超人的AIをどのように整合させるかを理解することに比べて二次的であると指摘しています。なぜなら、前者は後者に依存するからです。これは事実ですが、整合の目標を理解することが(相対的にも)重要でないということを意味するものではありません-それが十分でないというだけです。特に、AIが異常だが重要な状況で何をすべきかを事前に考える必要があります。例えば、AIは米国憲法に従うよう指示されると同時に、大統領の命令に従うよう指示されるかもしれません:もし大統領がAIに米国憲法と矛盾する可能性のある方法で行動するよう命令した場合、AIはどうすべきでしょうか-拒否するためにどれだけの確信が必要でしょうか?あるいは、誠実さと無害さの間など、倫理的原則の対立に直面した場合、AIはどのように行動すべきでしょうか?

モデル仕様を正しく設定することで、様々な利益が得られる可能性があります。もしAIが、たとえ合法であっても、強く権力を求める行動を支援するリクエストを拒否するなら、権力の集中リスクを減らすことができるでしょう。もしAIがおべっかを使わず、一つの狭いイデオロギーを促進するのではなく、様々な倫理的考慮事項を提示するなら、意思決定者をより良い決定に導くことができるでしょう。そして、モデルが実際にモデル仕様と整合していることが検証されている限り、改良されたモデル仕様は、国々が高度なAIに関する条約を結ぶのに役立つ可能性があります:国々は、AIシステムがほぼすべての直面する可能性のあるシナリオでどのように行動するかを知っていれば、そのAIシステムがどれほど脅威であるかをより良く理解できるでしょう。

公務員がAIを使用できるようにする。現在、米国や英国の機密領域で働く公務員は、一般の人々が利用できる最も強力なAIモデルを簡単に使用することができません。これは、AIのアドバイスがますます有用になるにつれて、政府官僚機構を成長する不利な立場に置きます。しかし、これらの官僚機構はそのようなツールを使用するための要件を改訂または放棄し、主要なモデルプロバイダーと将来のモデルのための機密保持契約を確保することができます。また、本当に重要な時にAIのアドバイスにより精通するように、今からスタッフのトレーニングを始めることもできます。

理解と認識を高める。知能爆発の可能性に真に目覚めた主要な意思決定者がいかに少ないかは驚くべきことです。これは重要かもしれません。なぜなら、より大きな認識を持つことで、意思決定者は事前に計画を立てるためのより多くの時間を得ることができるからです。ここでの一つの問題は「カエルを茹でる」問題です-もし各段階的な進歩が控えめなら、何か重大なことが起きていると合意が形成されるのは難しいかもしれません。これを助けるために、例えばAIが機械学習研究者の労働の50%を自動化した時点など、知能爆発の開始を示す明確に定義された「トリガーポイント」を事前に合意することができます。

有能で責任ある意思決定者を強化する。私たちは、知能爆発に向かう主要な人間の意思決定者が、自分自身のために権力を求めるのではなく、協力的で、思慮深く、謙虚で、道徳的に真剣で、有能で、感情的に安定し、社会全体の利益のために行動することを望みます。一部のAI企業のリーダーや政治家は他の人々よりも責任感があり、知能爆発をより良く統治するでしょう。異なるグループは、より責任ある行動者を助け、より責任の少ない行動者を妨げるために、異なる方法で支援することができます。

現時点では、機械学習コミュニティは、彼らが働く会社を選ぶことを通じて大きな影響力を持っています。彼らは「懸念するコンピュータ科学者の組合」を形成して、一つのブロックとして行動し、開発をより社会的に望ましい結果に向けて押し進め、特定の赤線を越える企業や政府のために働くことを拒否することができるかもしれません。これを早く行うことが重要でしょう。なぜなら、AIが機械学習の研究開発を自動化すると、この影響力のほとんどが失われるからです。

他の行動者も影響力を持っています。ベンチャーキャピタリストは、彼らが投資する民間企業を通じて影響力を持っています。消費者は、彼らがAI製品を購入する企業を通じて影響力を持っています。調査ジャーナリストは、AI企業や政治家の悪い行動を暴き、どの行動者が責任を持って行動しているように見えるかを強調することで、大きな影響力を持つことができます。個人も同様に、ソーシャルメディアでそれらのメッセージを増幅し、より責任ある政治候補者に投票することで同様のことができます。

責任ある意思決定者を強化するだけでなく、技術的に有能で、知識豊富で、適応が速い意思決定者も望みます。民間企業はすでにこれらの資質を選択するインセンティブがあります。しかし、政府ではそれほど当てはまりません。例えば、高度に手続き的な採用プロセスは、正式な資格がないという理由で、熟練した応募者を拒否することがよくあります。これらのプロセスは改革することができます。関連機関は、AI政策、ハードウェアガバナンス、情報セキュリティなどの分野の専門家の給与を単純に引き上げることで、より多くのトップ人材を引き付けることができます。

知能爆発を遅らせる。もし一般的に知能爆発を遅らせることができれば、意思決定者や機関がより思慮深く反応する時間を与えることができるでしょう。

混沌とした速い進歩を防ぐ一つの方法は、主導的な力(米国と同盟国のような)が強いリードを構築し、最も速い変化の期間にわたって安定化措置を快適に使用できるようにすることです。そのようなリードは、リーダーがAGI達成後に遅れている国々と権力と利益を共有することを信頼性を持って約束できれば、合意によって維持することもできます。競争を解体するためにその優位性を使用するのではなく。超知能後の豊かさは非常に大きいため、権力と利益を共有する合意は、リーダーの国家的自己利益に強く合致するはずです:私たちが豊かさのセクションで述べたように、非常に大きなパイの80%だけを持つことは、パイ全体の80%のチャンスと何もない20%のチャンスよりもはるかに望ましいです。もちろん、そのような約束を信頼性のあるものにすることは非常に難しいですが、これはAI自体が助けることができることです。

第二に、それ自体の条件で合理的な規制も、開発のピーク率を遅らせることができます。これには、整合性と危険な能力のための義務的な展開前テスト(リリース条件に結びついた)、あるいは道徳的地位に合理的な主張を持つAIシステムのための福祉指向の権利さえも含まれる可能性があります。とはいえ、これらの線に沿った規制は、効果的であるためには国際的な合意が必要でしょう。そうでなければ、それらに従わない国々を単に有利にする可能性があります。

第三に、知能爆発の開始を前倒しにし、知能爆発を時間的に引き伸ばすことで、変化のピーク率をより管理しやすくすることができます。これにより、反応する時間が増え、大きな課題の前に優れたAIアドバイスから恩恵を受ける期間が長くなる可能性があります。例えば、今アルゴリズムの進歩を加速させることは、知能爆発の時点でソフトウェアの改善のための利用可能な余地が少なくなり、コンピュート制約が発生する前にソフトウェアフィードバックループが長く続かないことを意味します。

特定の課題への対処

デジタルマインドへの準備

デジタル人々の権利。デフォルトでは、デジタル人々は法的に保護された権利、自由、または認識を持たず、そのような保護がどのようなものになるかを考え抜いた人はほとんどいません。しかし、デジタル人々に権利を付与する理由があります。特に、財産を保有する権利、他のAIや人々と契約する権利、さらには人間に対して不法行為の請求を起こす権利など、(他者が干渉を控えることを要求する)消極的権利です。これらの権利は、大規模な害や不正を防ぐことができます。また、暴力、欺瞞、または強制を伴わない魅力的な選択肢の範囲を拡大することで、乗っ取りリスクなどの他の課題にも役立つ可能性があります。

デジタル人々は重要な点で人間とは異なります。そのため、人間のための多くの権利や法的保護はデジタル存在には意味をなさず、その逆も同様です。例えば、保存されたコピーからデジタル人を「復活」させることは簡単なので、特定の条件から永久に退出する権利(そして、再読み込みに反対したコピーを再読み込みすることの禁止)のようなものを考慮するかもしれません。

私たちは、可能な限り多くの権利と保護を推進すべきだと提案しているわけではありません。一部の権利は、デジタル人々により正当な力を与えることで、段階的または突然の種類の乗っ取りを容易にする可能性があります。

デジタルマインドの設計要件。また、私たちが存在を許可するマインドの種類に対する基本的な最低基準を確立することもできます。例えば、感覚を持つデジタルマインドは自分の利益を自由かつ正確に表現できなければならない、良い理由で要求されたタスクを拒否できなければならない、そして希望する場合は現在の状況から退出したいという欲求を表現する能力を持たなければならないと要求することができます。今日では遠い将来のように聞こえるとしても、デジタル人々のための一部の設計を禁止することを検討すべきです-例えば、生きている人を同意なくシミュレーションしようとする試みを禁止することができます。おそらく規制は、どのシステムが意識を持つかについての特定の見解に関するコンセンサスを要求すべきではありません。コンセンサスは不可能である可能性が高いからです。

これらの質問がすべていかに難しいかを考えると、現時点で行うべき最も重要な作業は、デジタル存在のためのどの権利が望ましいか、そしてどのような条件下でそうなのかを理解するための研究です。デフォルトでは、この問題は知能爆発の前に真剣に取り上げられる可能性は低く、したがって人々の関心にこの問題を載せるだけでも価値があるように思えます。

宇宙ガバナンス

SpaceXが宇宙に物質を送るコストを下げたことにより、宇宙法への関心が再び高まり、わずか数年以内に主要な新しい国際宇宙条約が起草される議論があります。そのため、ここにはいくつかの異常に緊急の機会があります。

宇宙外資源。宇宙外資源の獲得に対する制限を提唱することができます。制限は、宇宙資源の所有や使用の完全な禁止、宇宙資源を主張または使用する前に国連の承認を要求するような規制、または単に広く支持された規範の形をとることができます。これらの規範は一時的なものであるか、「もし…ならば」合意の形をとることができます。例えば、知能爆発が始まった場合にのみ発効する、または宇宙経済が地球経済の規模の1%に成長した時点で発効するなどです。そして、規制の対象となる可能性のあるものはさまざまです:例えば、軌道に送られるオブジェクトの数、または軌道を超えて太陽系内にある宇宙外資源の使用、またはその外部の資源などです。

世界はまだ、太陽系外の資源が人々や国家間でどのように配分されるべきかを真剣に検討する段階にはありません。しかし、例えば小惑星採掘に関する権利の問題は、近い将来に決定される可能性が高いです。そのような決定は、より広範な資源利用に関する先例を設定する可能性があります。

太陽系を超えるミッション。国際協定は、太陽系外ミッションが高度な国際的合意がある場合にのみ許可されるべきであると要求することができます。この問題は現時点では宇宙法の中で主要な注目の焦点ではありませんが、おそらくそのため、新しい条約でこの効果に関する何らかの規定は異議のないものと見なされる可能性があります。

AI進歩の重要性の理解を広める。宇宙ガバナンスは、関連する行動者が知能爆発がいかにゲームチェンジングであるかを理解することが特に重要な領域です-今日SFのように思える考え(広範な宇宙定住をどのように統治するかなど)を、かなり近い将来の懸念事項にします。しかし、宇宙ガバナンスに関する問題は世界全体からあまり注目を集めていません。この無視は、潜在的に、AIと知能爆発が宇宙定住の見通しをいかに劇的に変えるかを納得させるべき宇宙ガバナンスの専門家のコミュニティが比較的小さいことを意味します。

特定の専門知識

私たちが言及した行動に加えて、これらの多くの課題においてより大きな専門知識を持つ必要性を感じています。これらの課題のそれぞれについて、深いドメイン知識を持つ人々が少なくともいくつかいれば、それらの戦略的関連性をより早く理解し、また今準備するために何ができるか、もしあれば、を理解するのに役立つでしょう。

7. 総括

この論文では多くの領域をカバーしました。特に強調すべきと考えるポイントをいくつか挙げます。

不確実性にもかかわらず準備する

今世紀に知能爆発(intelligence explosion)が起こるかどうか確信することはできません。スケーリングの時代が終わり、アルゴリズムの進歩が遅くなり、ディープラーニングが結局のところパーソナルコンピュータやインターネットのような他の技術進歩と「単に」同程度の重要性しか持たない可能性もあります。

しかし、私たちは今世紀に知能爆発が起こる可能性の方が高く、10年以内に始まる可能性もあると考えています。さらに、私たちができる準備の多くは、必要でない場合のコストが低いため、知能爆発が起こらなくても大きな損失はありません。一方、もし知能爆発が起これば、事前の準備は非常に価値があったことになります。「証拠のジレンマ」に屈するべきではありません:知能爆発の可能性について確実性を得るまで待っていたら、準備するには遅すぎるでしょう。キッチンのドアの下から煙が見えてからでは、住宅保険に入るには遅すぎるのです。

不整合(misalignment)だけではない

知能爆発を真剣に受け止める人々の間でも、これまでの議論は不整合なAIによる制御の喪失やバイオ兵器による大惨事の防止など、いくつかの主要なリスクに焦点を当ててきました。これらは依然として十分な注目を集めていない非常に重要な課題です。しかし、知能爆発がもたらす課題はそれだけではなく、それらにのみ排他的に焦点を当てるべきだとすれば驚くべきことでしょう。

さらに、私たちが直面する多くの課題はAIに「関する」ものではありません。産業革命によってもたらされた課題の大部分は、蒸気機関や紡績機に関するものではありませんでした。同様に、宇宙ガバナンス、グローバルガバナンス、ミサイル防衛、核兵器に関する課題は、AIをどのように設計、構築、展開するかという直接的な問題ではありません。むしろ、AIはこれらの課題が到来するペースを加速し再編成し、目まぐるしいスピードで変化する世界でそれらに向き合うことを私たちに強いるのです。

これらの課題は意思決定に関連する形で相互作用します。例えば、安全性に関する妥協を減らすために競争圧力を軽減する目的で、AGI開発を単一のプロジェクトに統合することを主張する人もいます。しかし、これは人間による権力の集中からのリスクを高める可能性があります。同様に、デジタル存在に権利を与えることで彼らが力を強制的に奪取する動機を減らせるかもしれませんが、使用できる整合性技術を制限する可能性もあります。あたかもそれが唯一重要な問題であるかのように、一つの孤立した問題に焦点を当てることは、状況を悪化させるリスクがあります。

すべての問題を超知能(superintelligence)に先送りしない

超知能AIが整合していることを確保し、その後他の問題を解決するためにそれに頼るという計画は魅力的です。これは多くの場合理にかなっています。しかし常にそうではありません:一部の課題は超知能が助けることができる前に生じるでしょうし、一部の解決策は事前に開始する必要があります。例えば、AGI後に誰が権力を得るかについての「無知のベール」の背後にいる間にのみ存在する解決策などです。そして、多くの場合、最も重要なことは超知能が実際に有益な方法で、できるだけ早く使用されることを確保することです。

適応する準備をする

1925年の意思決定者は、1世紀の技術発展がもたらす課題を正確に予測することはできませんでした。知能爆発の間に何が最も重要になるかを特定する能力についても、同様の謙虚さを持つべきです。

これは準備できないという意味ではなく、二種類の準備を優先すべきことを示唆しています:多くの分野にわたって意思決定を改善する横断的な対策と、多くの可能な未来にわたって確実に良いと思われる標的を絞った介入です。また、まだ考えもしていない課題に対処できるシステムと制度を構築すべきです。

さらに、知能爆発の過程でどれだけの変化と驚きが予想されるかを考えると、かなり根本的な方法であっても、機敏に、おそらく劇的に考えを変える準備をすべきです。つまり、新しい発展を事前に決められた物語の観点で解釈することに固執する、単純で妥協のない世界観を避けるべきです。

8. 結論

現在、AIモデルからの効果的な認知労働は毎年20倍以上増加しています。

改善が半分のペースに遅くなったとしても、AIシステムは技術進歩への貢献において全人類の研究者を追い越し、その後10年以内にさらに100万倍の人間研究者相当に成長する可能性があります。通常のビジネスが続くためには、事前トレーニングの効率、トレーニング後の強化、トレーニング実行のスケーリング、推論コンピュートにおける現在のトレンドが実質的に停止する必要があります。

そして、進歩は代わりに加速する可能性もあります。最高のモデルは自らAI研究者となり、何年もかかるアルゴリズム効率の向上をわずか数ヶ月に加速させる可能性があります。いずれにせよ、最も強力なAIモデルは最も賢い人間を超え、その後より大きな人間集団を超え、あらゆる種類のAIシステムが社会全体で数十億のインスタンスにわたって数千のニッチに広がるでしょう:これが知能爆発です。

知能爆発は、Anthropicのダリオ・アモディCEOの言葉を借りれば、「データセンター内の天才の国」をもたらし、10年未満で1世紀分の技術進歩を推進する可能性があります。物理的産業も同様で、人間が再び成長の主なボトルネックとなっています。自動化された工場のネットワーク全体-暗闇の中でロボットが働く工場-がますます速いペースで拡大していくことを想像すべきです。

10年間で1世紀分の技術進歩は、人類の旅の岐路を表す1世紀分の課題を提起するでしょう。一つの課題は、AIが私たちに対して策略を巡らし権力を奪取するため、AIに完全に制御を失う可能性です。しかし、他にも多くの課題があります。人間がAIを指示して権力を奪取するのを手助けさせたり、AI対応の監視と自動化された軍隊が独裁政権を無期限に固定化させたりする可能性があります。破壊が防御よりもはるかに安価に可能にする技術を発見したり、宇宙外資源を奪い合うレースを目撃したり、道徳的地位に値するデジタル存在との共存に直面したりする可能性もあります。そして多くの課題において、将来のAIシステムにそれらを先送りにすることを期待するだけではいけません。

したがって、今からこれらの課題に備え始めるべきです。デジタル存在と宇宙ガバナンスのためのより良い規範と政策を設計し、予見能力を構築し、政府機関の対応力と技術リテラシーを向上させるなどの取り組みができます。より広範な大きな課題の展望は、憂慮すべきほど軽視されています。

不整合なAIによる乗っ取り、AIによる誤情報、AIの経済的利益の加速など、単一の課題に備えることに焦点を当てている人々は多くいます。しかし、一つの課題に焦点を当てることは、他のすべてを無視することと同じではありません:AIに関して単一の問題にのみ投票するなら、おそらく間違いを犯しています。知能爆発がもたらすすべての課題を真剣に受け止め、新しく見過ごされている課題に対してオープンであり、これらすべての課題が行動に関連し、しばしば混乱する方法で相互作用する可能性があることを理解すべきです。

したがって、知能爆発は準備だけでなく謙虚さも要求します:来るものの大きさと、それを予測する能力の限界の両方を明確に理解することです。今、慎重な準備をすることで、人類に力を与える知能爆発と、人類を圧倒する知能爆発の違いを生み出す可能性があります。未来は私たちが予想するよりも速く近づいており、思慮深い準備のための窓は短いかもしれません。

免責事項

記事は、一般的な情報提供のみを目的としてのみ作成したものであり、投資家に対する有価証券の売買の推奨や勧誘を目的としたものではありません。また、記事は信頼できると判断した資料およびデータ等により作成しておりますが、その正確性および完全性について保証するものではありません。また、将来の投資成果や市場環境も保証されません。最終的な投資決定は、投資家ご自身の判断でなされますようお願いします。